- TOP

- Lv.2_バックアップをもっと学ぶ人が読む記事

第1章 アプライアンス編

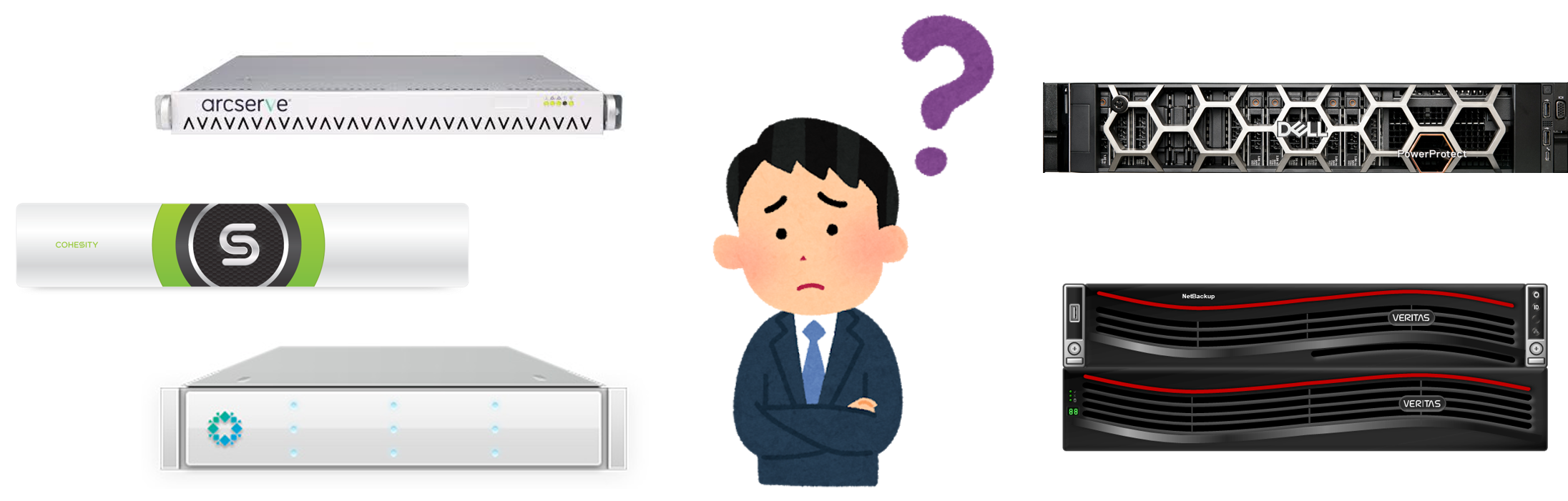

バックアップメーカー各社がアプライアンス型の製品を多くリリースしていますが、「いまいち違いがわからない」「安く導入できるx86サーバーとバックアップソフトの方がいいに決まってる」と思っていませんか?

アプライアンスは、“バックアップ専用”だから実現できる高機能を搭載しているんです。本記事を読めば、その価格に納得するはず。

あなたの環境は従来のソフトウェア構成とアプライアンス、どっちが最適?早速学んでいきましょう!

アプライアンスとは

ところでどうして最近はアプライアンス型が増えているのでしょうか?

前回も教えてもらいましたが、いまいち良くわかりません。

わざわざわしの元にきたということは、前回と同じ答えがほしいワケではなさそうじゃのう。何か困ったことがあったのかな?

お客様から沢山のメーカーが出しているアプライアンス製品の特徴と違いを最近よく求められるんですが、うまく説明できないんです。

各社の機能一覧を見ると、できる事はほぼ一緒じゃないですか。

でもなぜか値段が全然異なっていたり、各社の違いが良くわかりません。

バックアップに必要なものが全て一つに

まずはアプライアンス型のいいと思うところを上げてみてくれ。

障害の切り分け不要!一括サポート

その保守のメリットをもう少し詳しく説明してみてくれ。

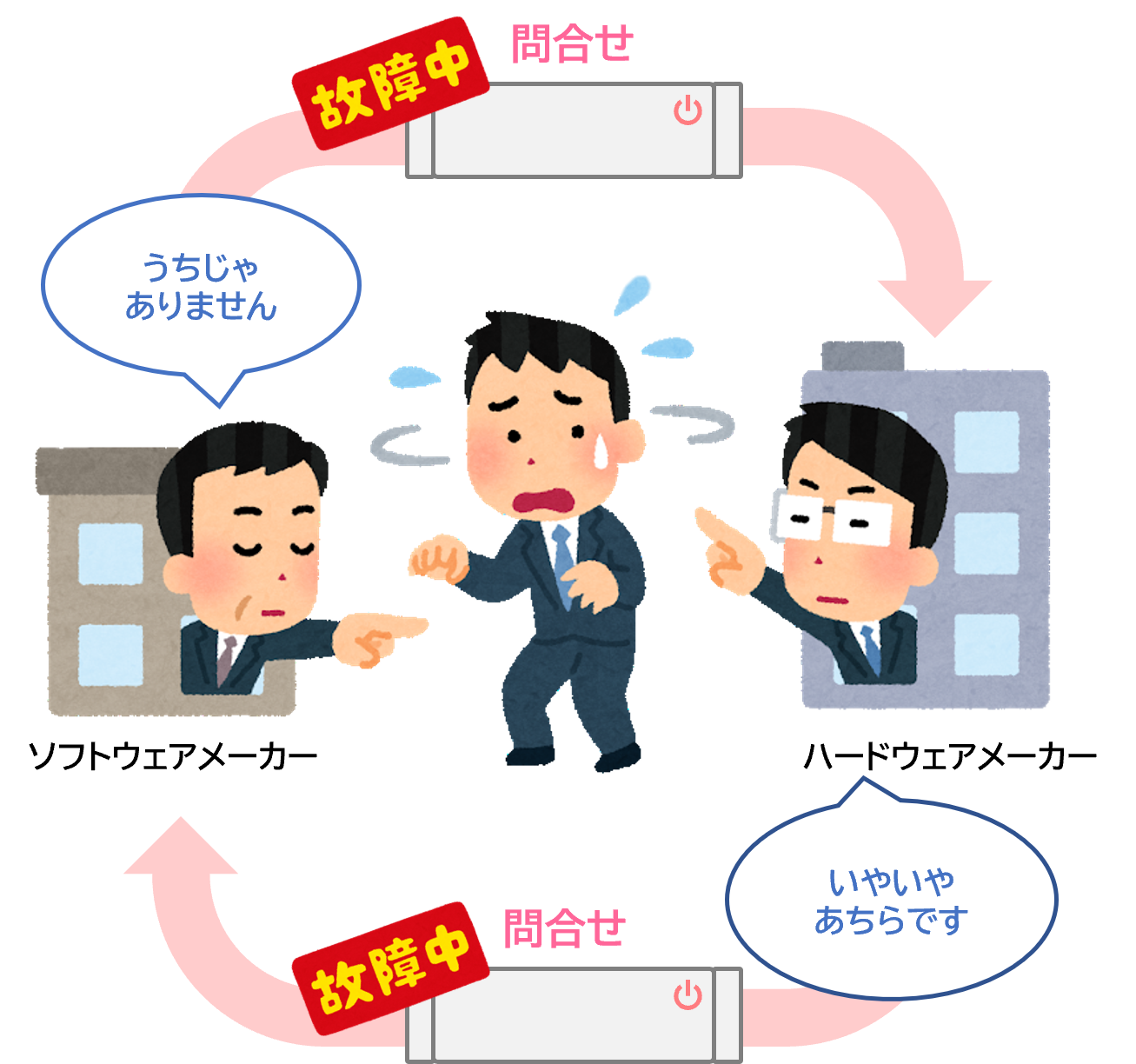

原因がどちらかわからない場合には、最悪保守をたらい回しにされて解決まで時間がかかるなどの問題もありました。

ハードウェアとソフトウェアの

メーカーが異なる場合

アプライアンスの場合

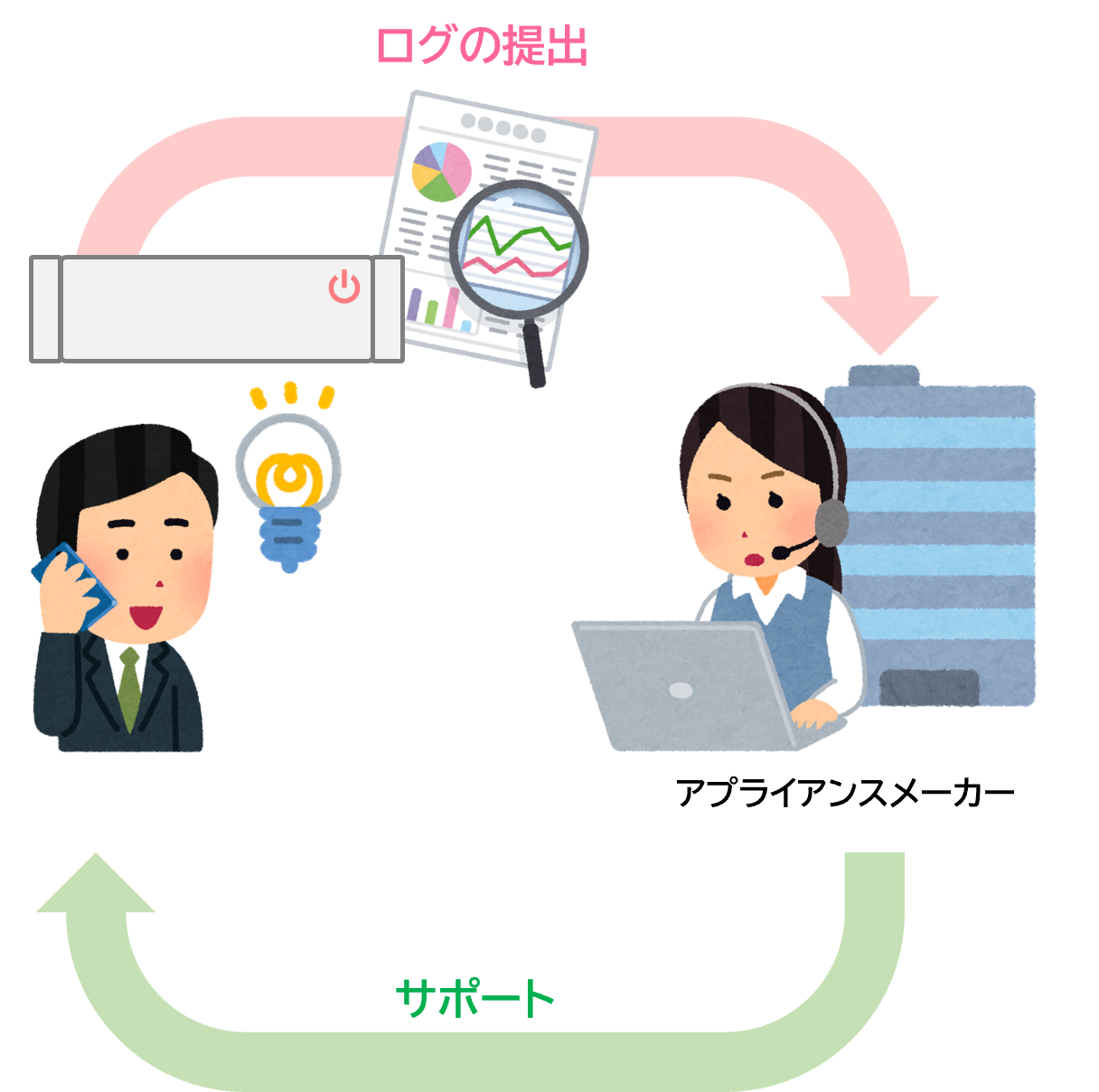

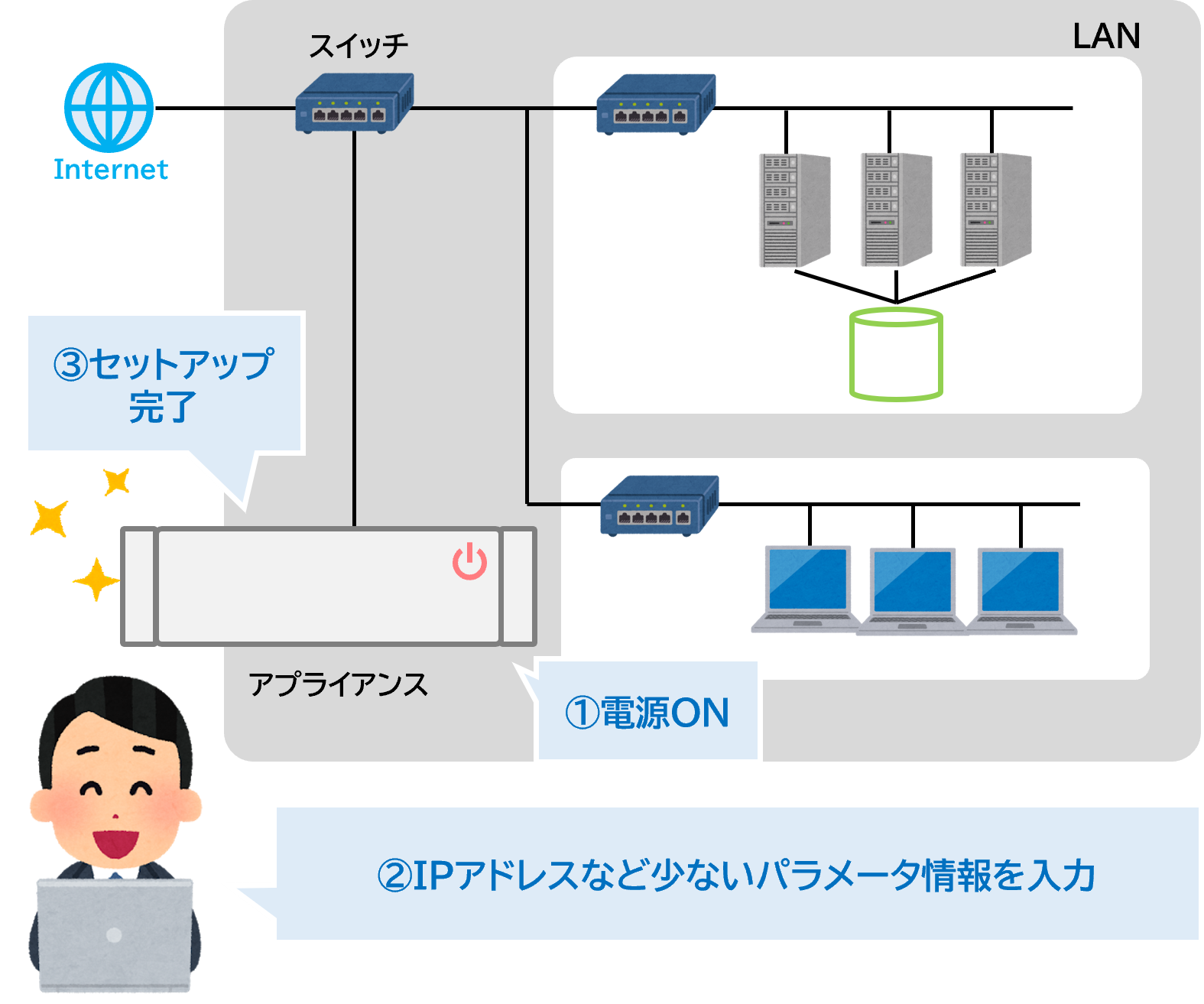

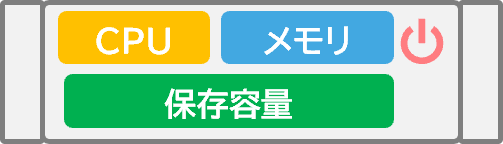

初期セットアップが簡単

やはりセットアップが非常に楽なイメージがあります。 電源を入れて事前に用意しておいたIPアドレスなどの情報を入れるだけで初期セットアップが完了するんですよね。

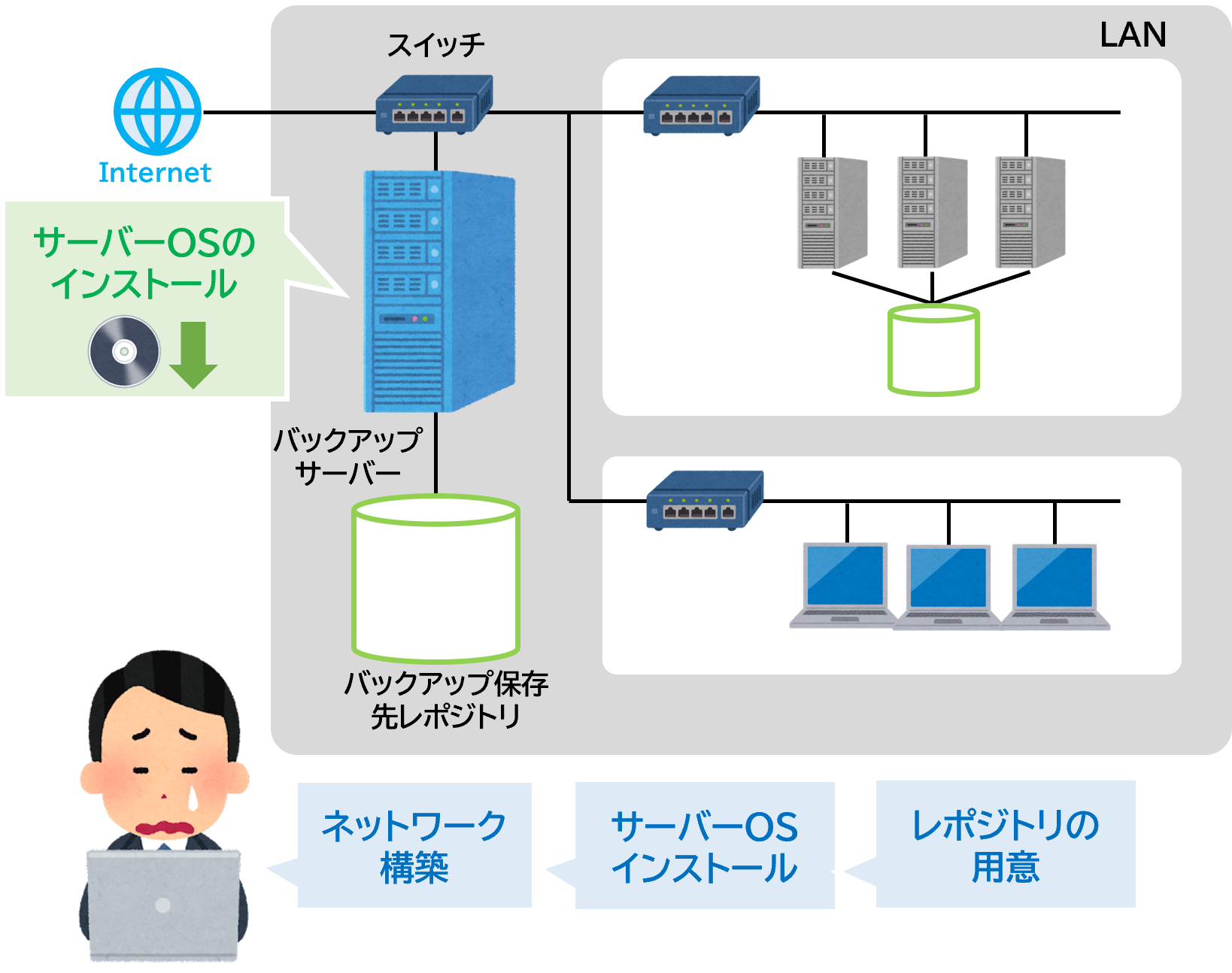

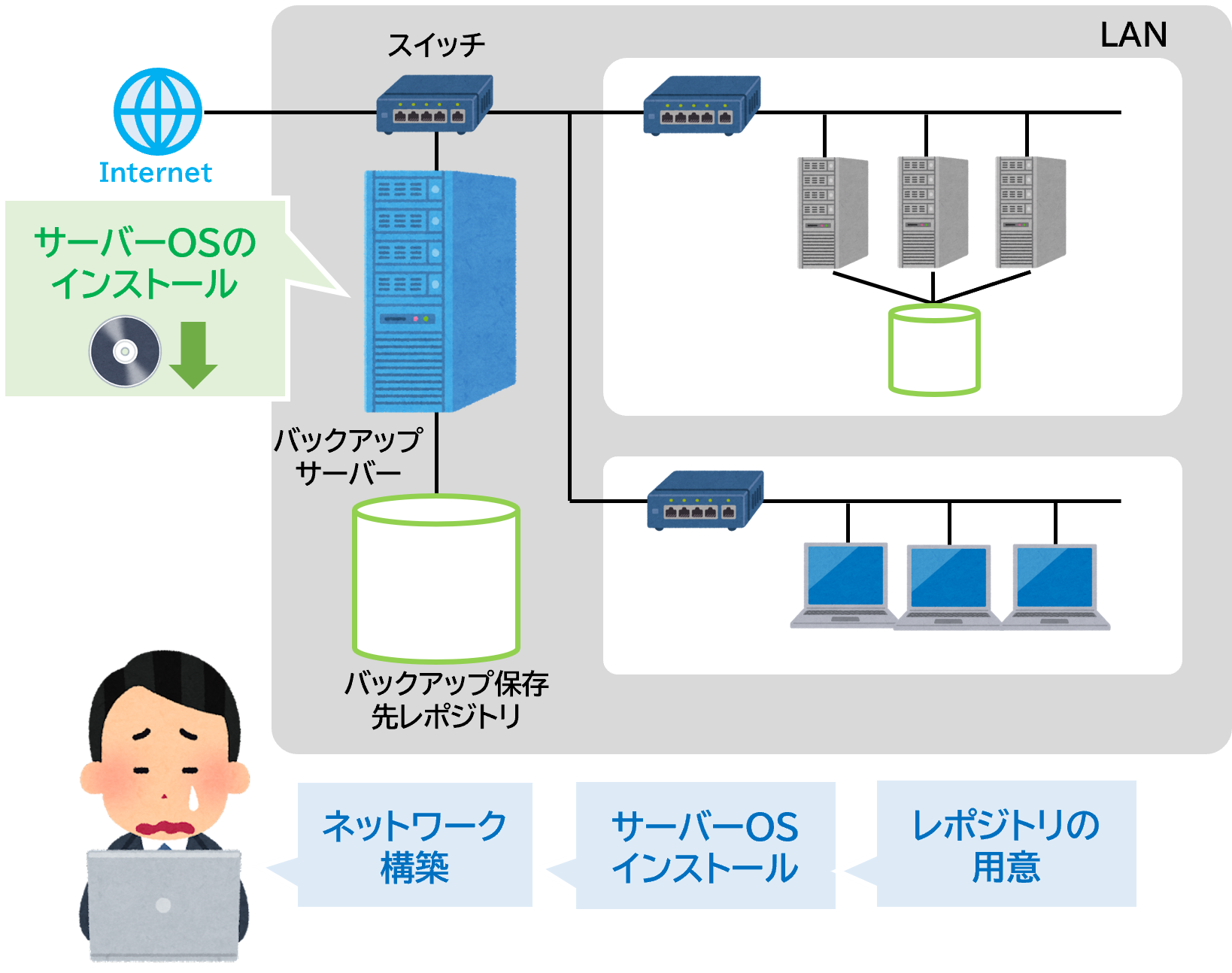

ハードウェアとソフトウェアをそれぞれ用意する場合

アプライアンスの場合

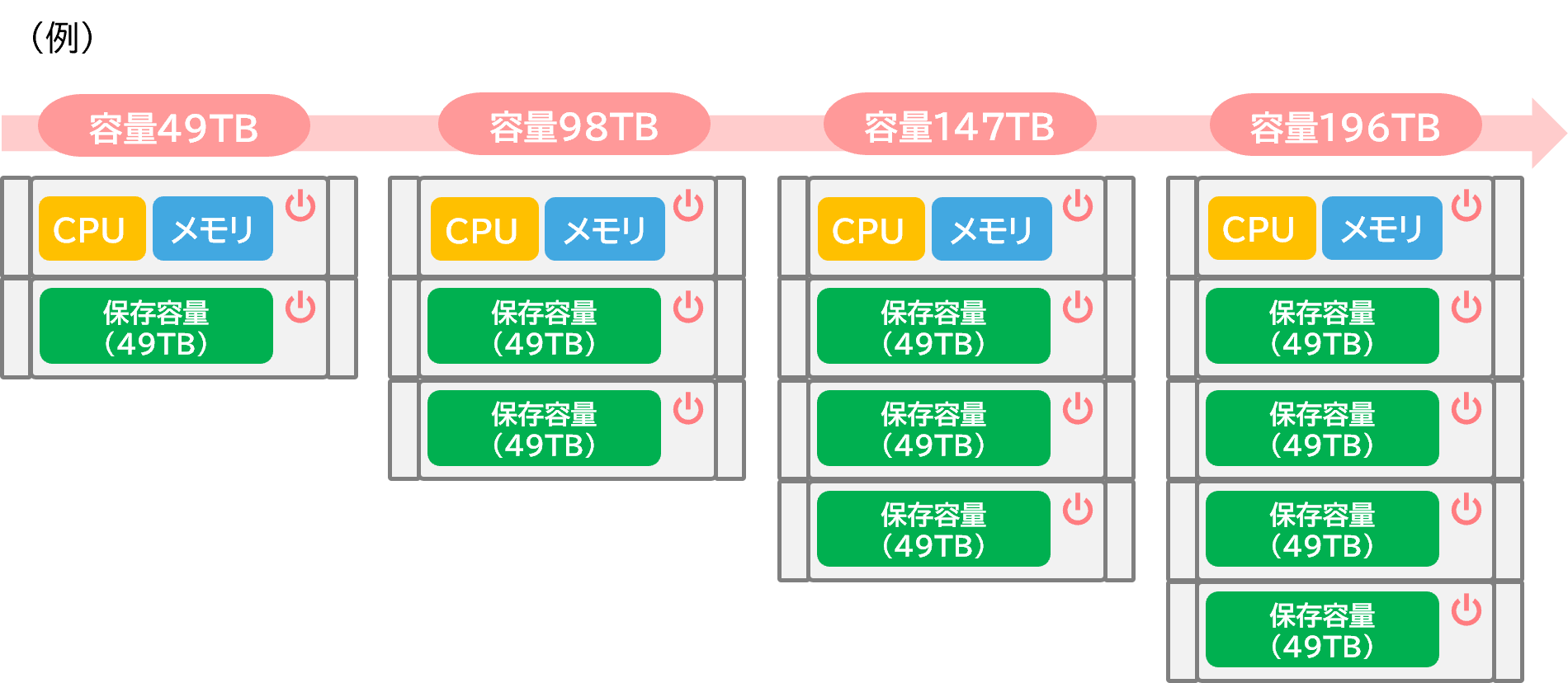

アプライアンスの自動拡張機能

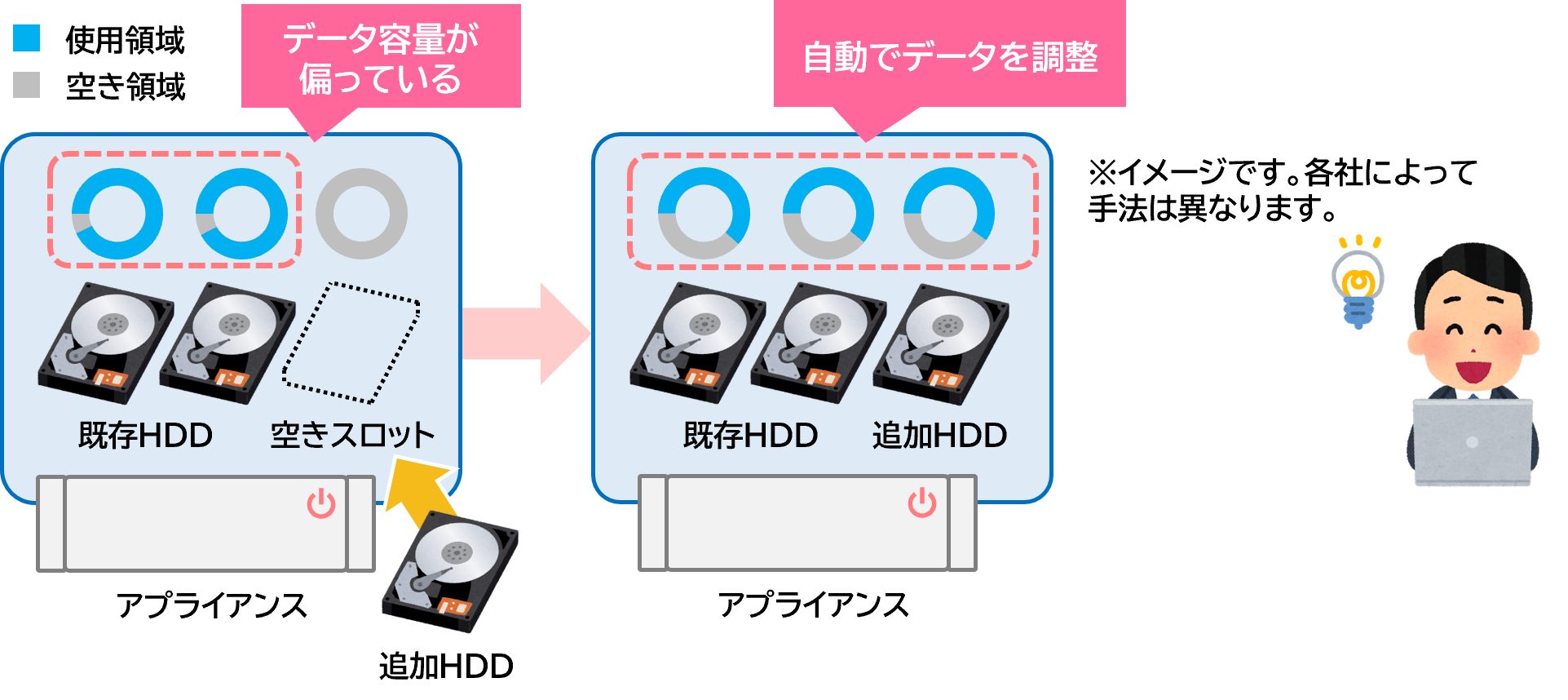

例えばセットアップだけでなく、容量追加の場合などの増設についてもメリットはある。例えば自動で拡張してくれる機能じゃ。

自動で拡張ですか。よくイメージできないんですが?

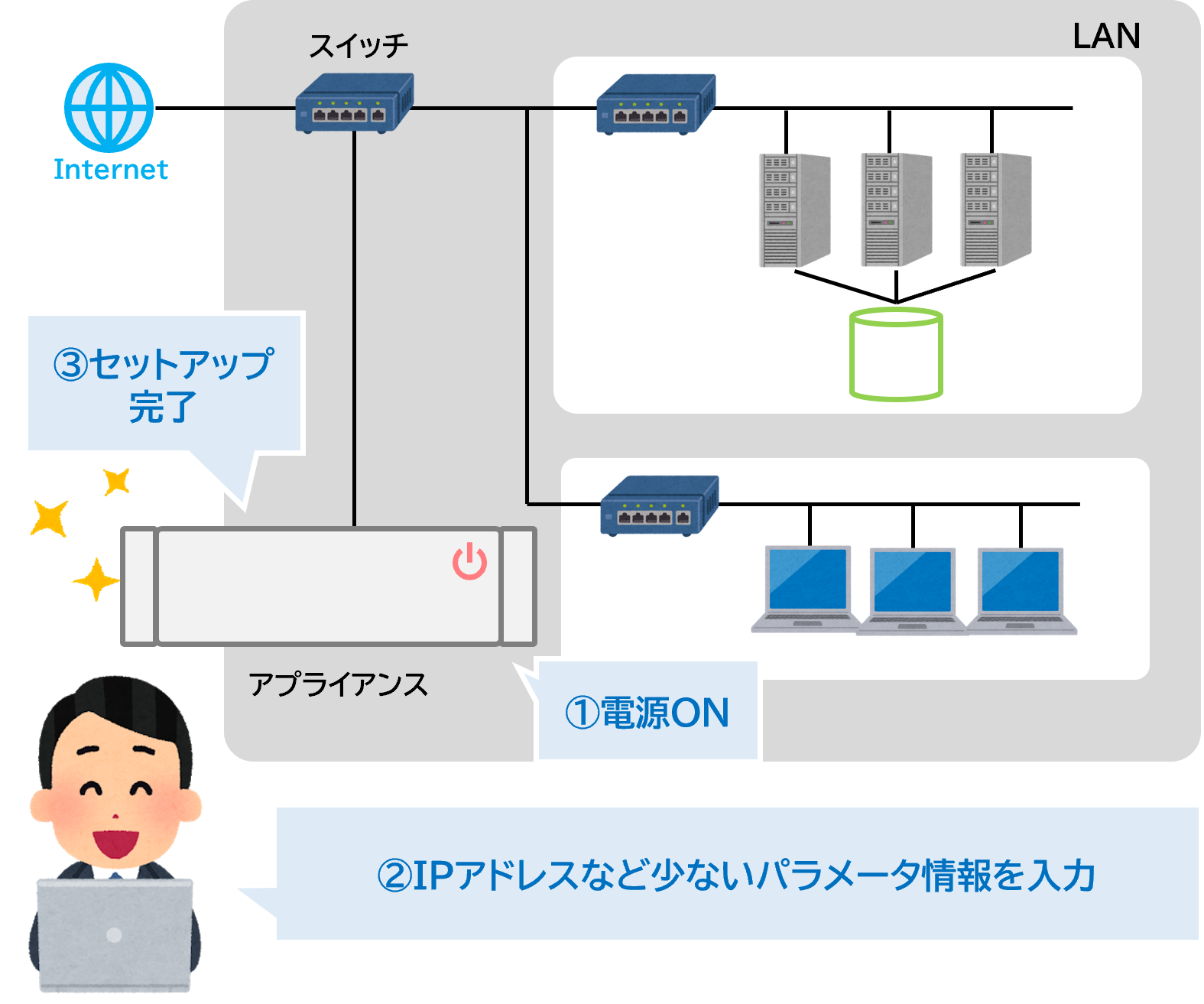

IDC やGartner などの調査会社や総務省の公開するデータどれを見てもデータは物凄い勢いで増えている。そして今後もますます増えていく事が予想されている。

詳細については Google で「データ増加率」などのキーワードで検索してみてくれ。

どの検索結果を見てみてもデータの増加率が減るなんて記事は見つからないはずじゃ。データが急激に増えている事で、今までのやり方だけではバックアップやデータ保護が間に合わなくなってきているのが事実である。

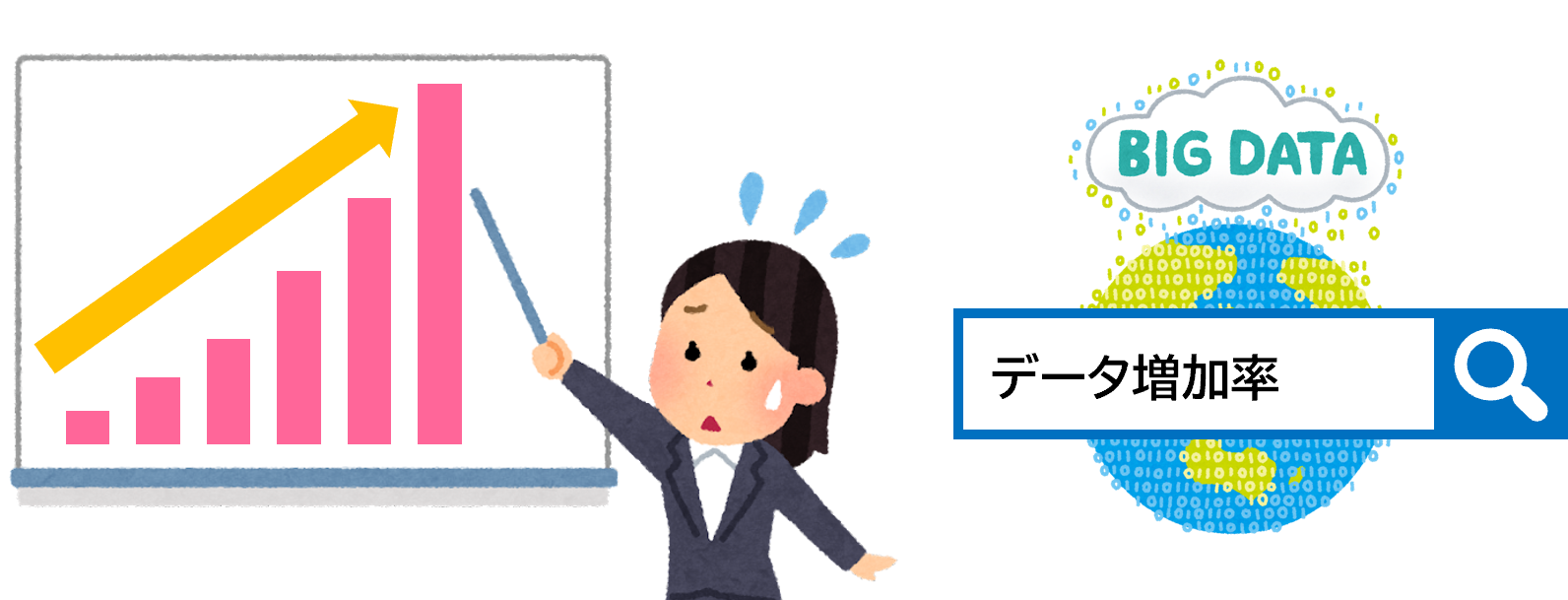

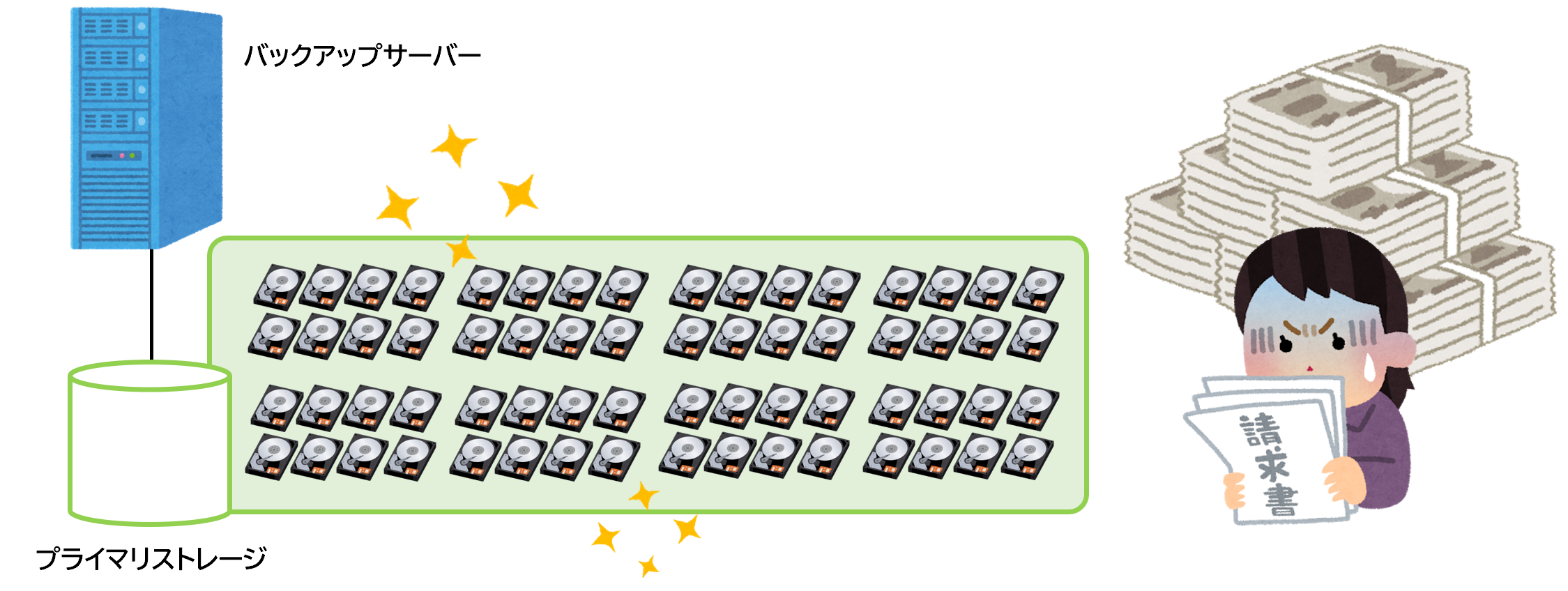

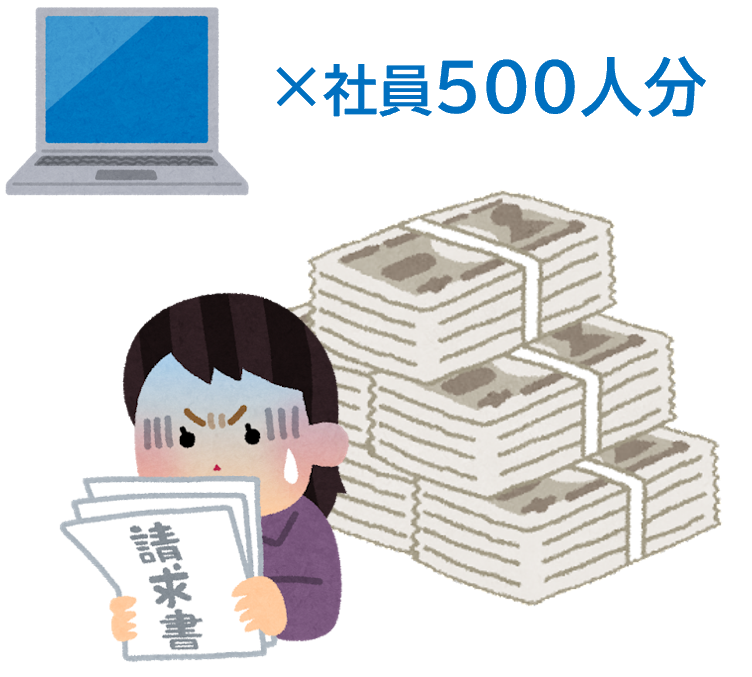

代表的な従来のバックアップシステム

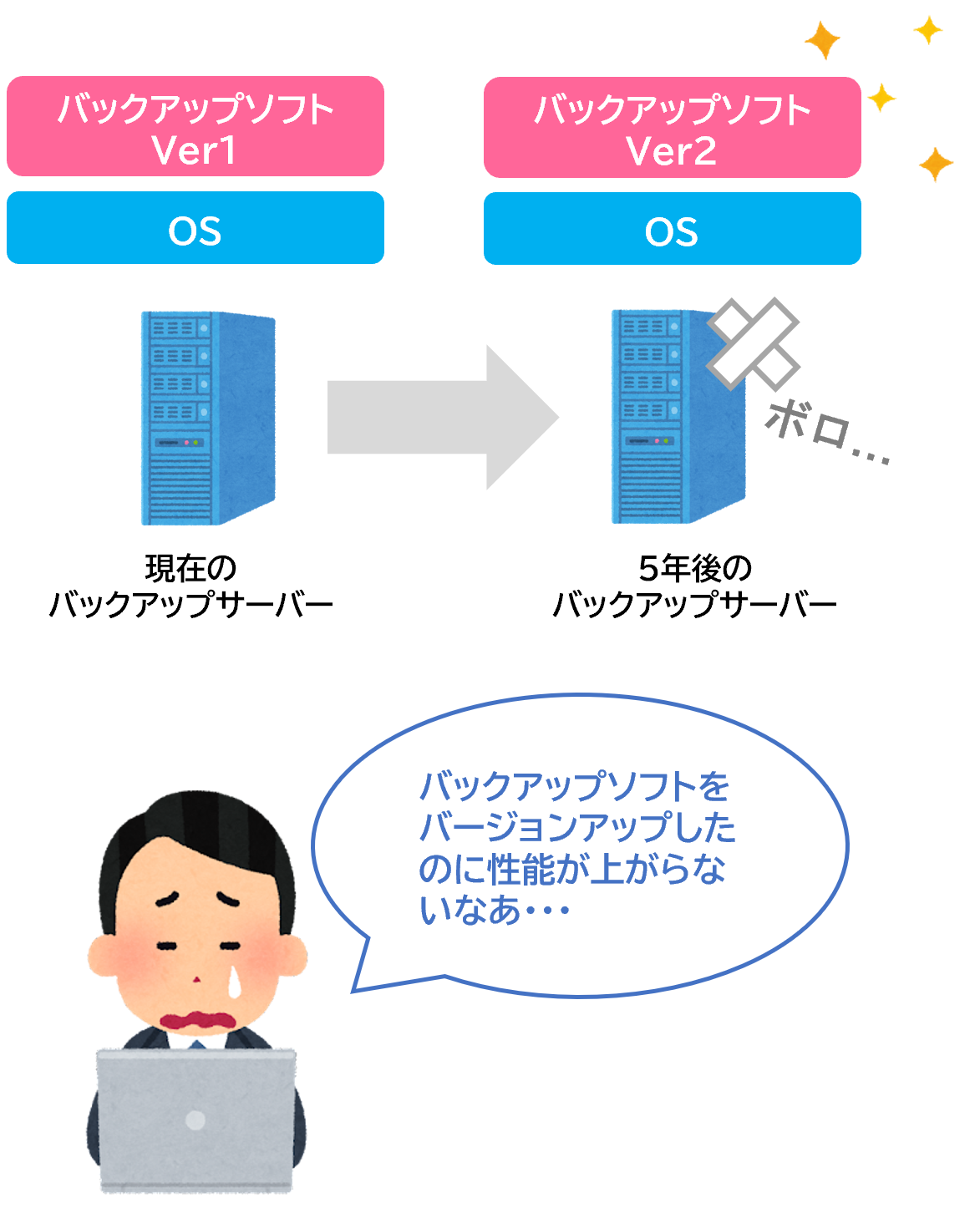

つまりデータの増加率が加速している今、そのハードウェアを5年間利用することを考えた場合に、5年後までの拡張性を考慮するのが難しいということじゃ。

バックアップソフトウェア自体は各社、切磋琢磨してより多くのデータ容量や混在環境をサポートできるように進化したんじゃ。

しかしハードウェア部分は、リニアにパフォーマンスや保存容量を増設するのは、今までの構成ではシステム的に難しいという問題が出てきたんじゃ。

拡張時、バックアップパフォーマンスの平準化作業を自動化

それがアプライアンスのメリットの1つである「拡張性」じゃ。

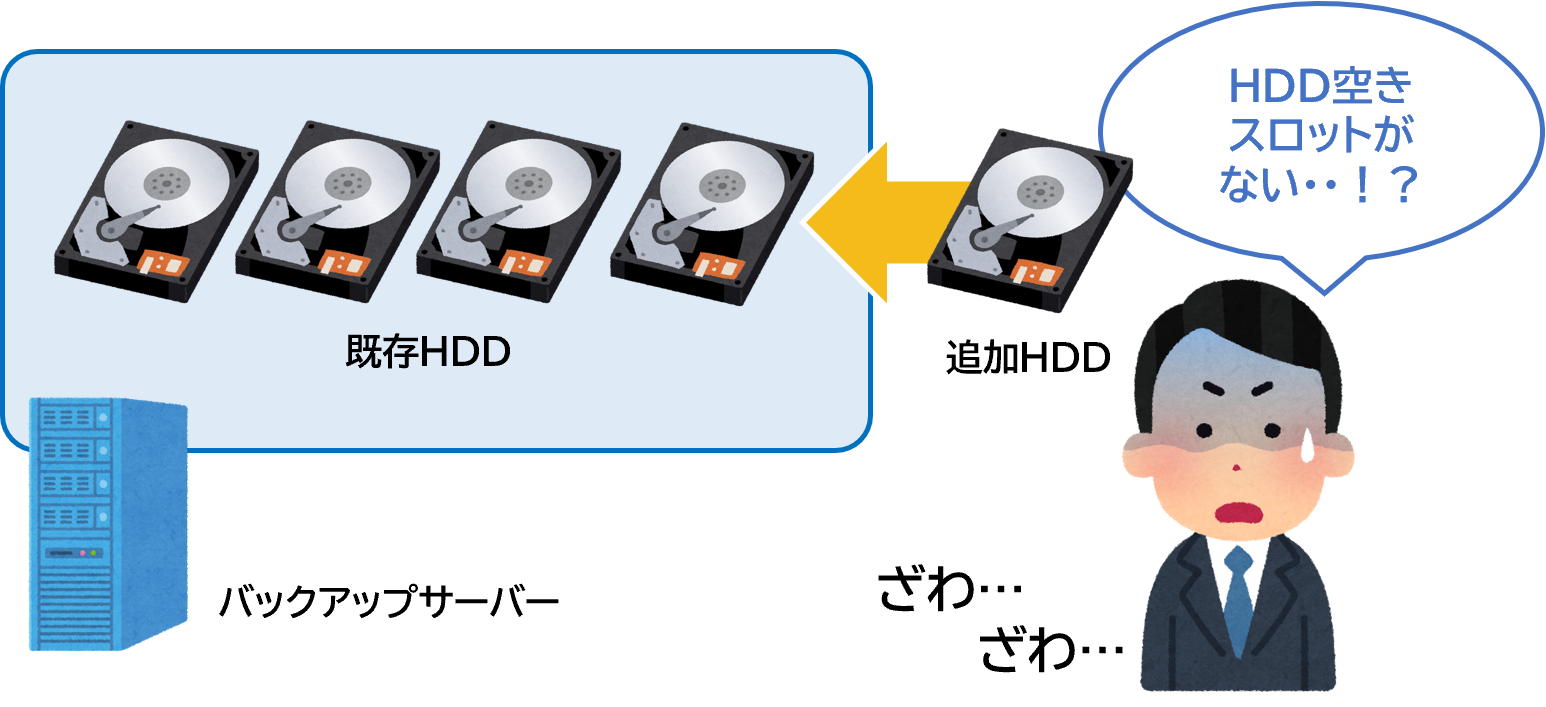

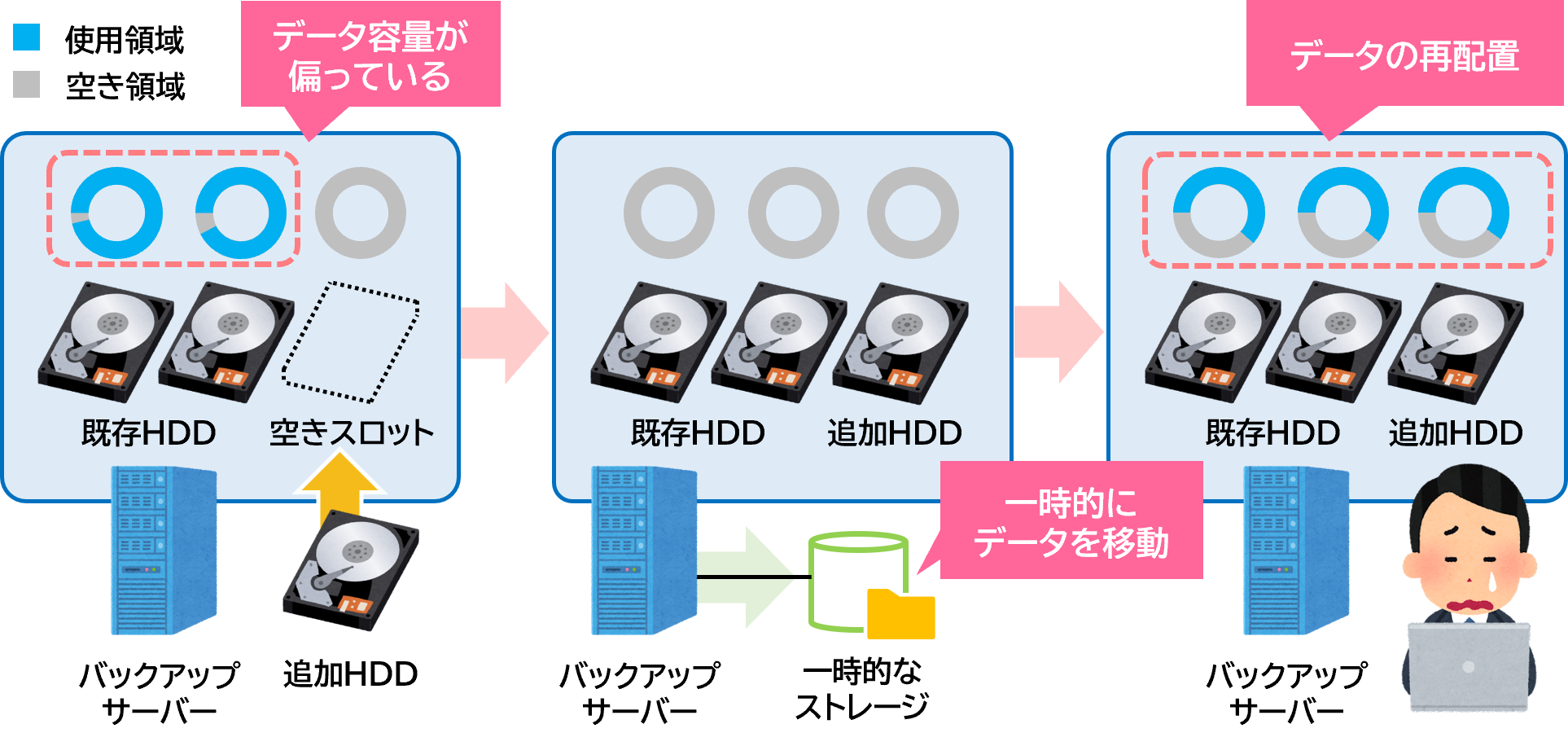

例えば今までの代表的な構成の具体例として、データの保存先がバックアップサーバー内蔵のHDDを利用している場合には、そのサーバー内に搭載出来るHDDの数が限度となる。

ディスクの使用量を平準化するために、一度容量を拡張後にデータを再配置したり、物によってはデータを一度別のボリュームに移動したりしてから、ボリュームを拡張して、データの再配置などの作業を行っていた。これが結構面倒だったんじゃ。

アプライアンスは、ほとんどの製品がこれらの作業を自動で行う機能を持っておる。

代表的な従来のバックアップシステムの場合

アプライアンスの場合

今まで管理者が行っていたバックアップパフォーマンスの

平準化作業をアプライアンスが自動でやってくれるんですね!

保存先をプライマリストレージにすればよくない?

代表的なプライマリストレージの一例

NetApp社 FASシリーズ

デル・テクノロジーズ社 Unity

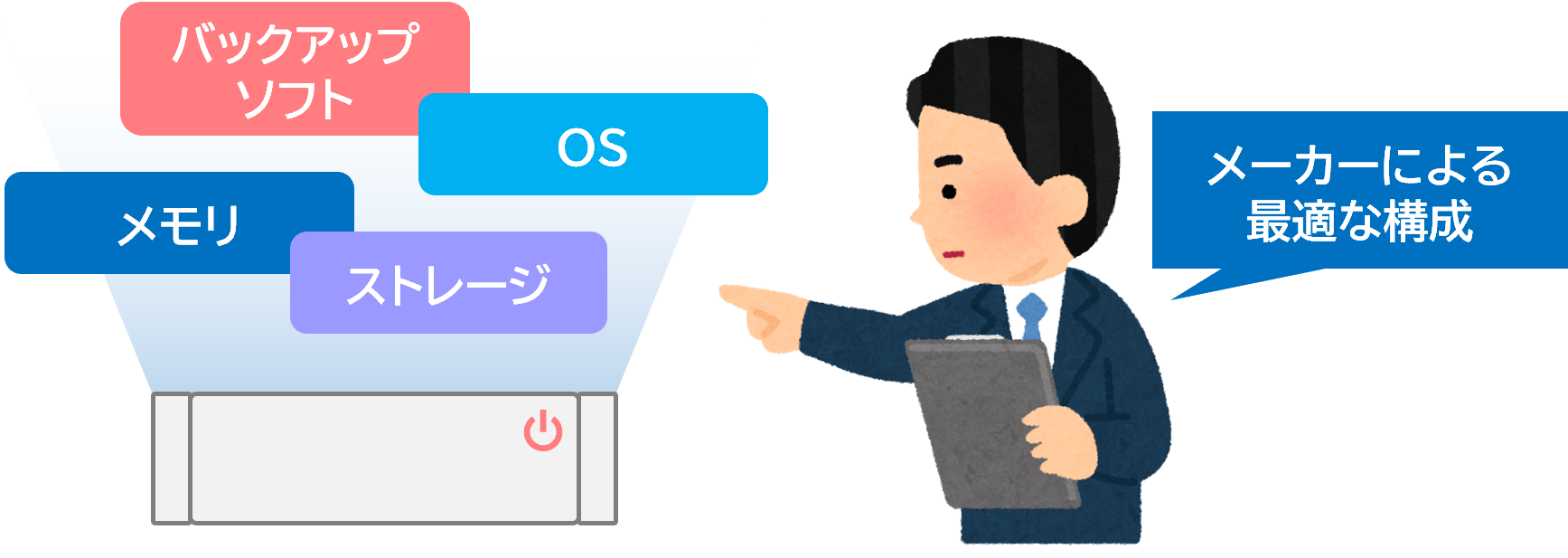

てっきりアプライアンス型はサーバーにバックアップソフトウェアをインストールして出荷されただけのものと考えていました。

アプライアンスのハードウェア構成

世界的にデータ激増中!バックアップ構成は昔よりも難しい

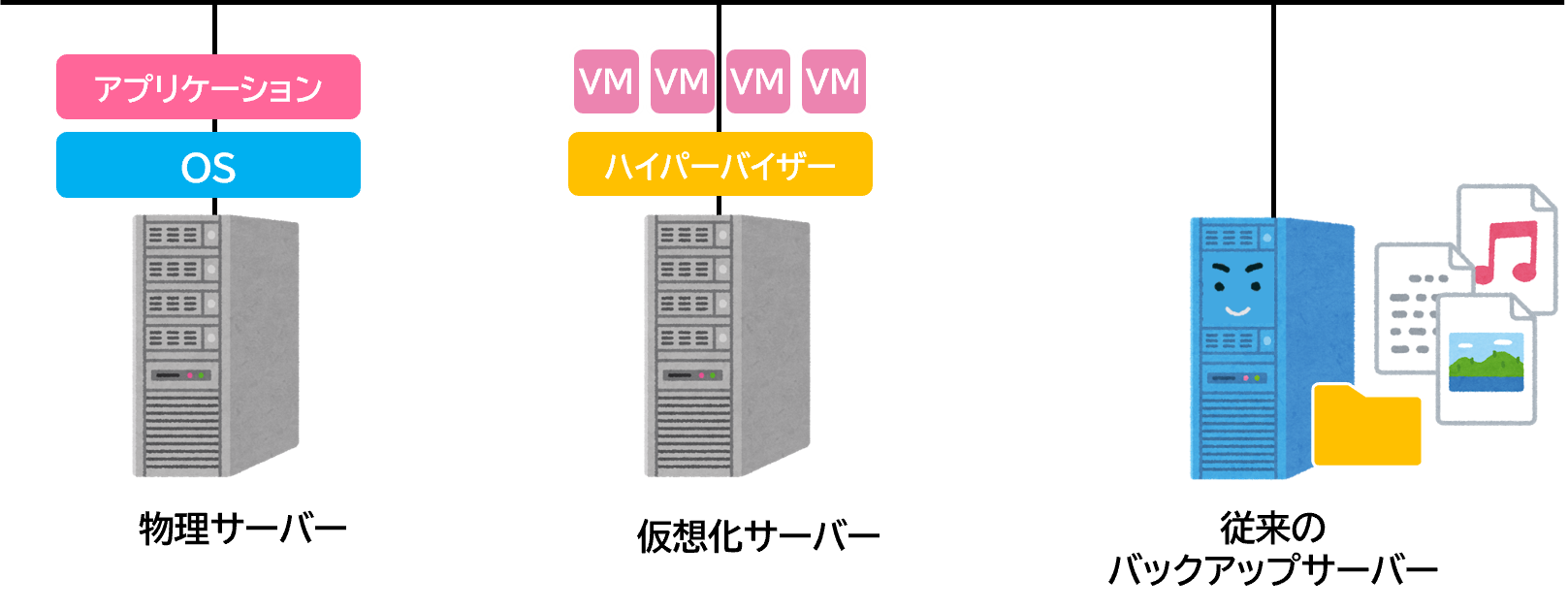

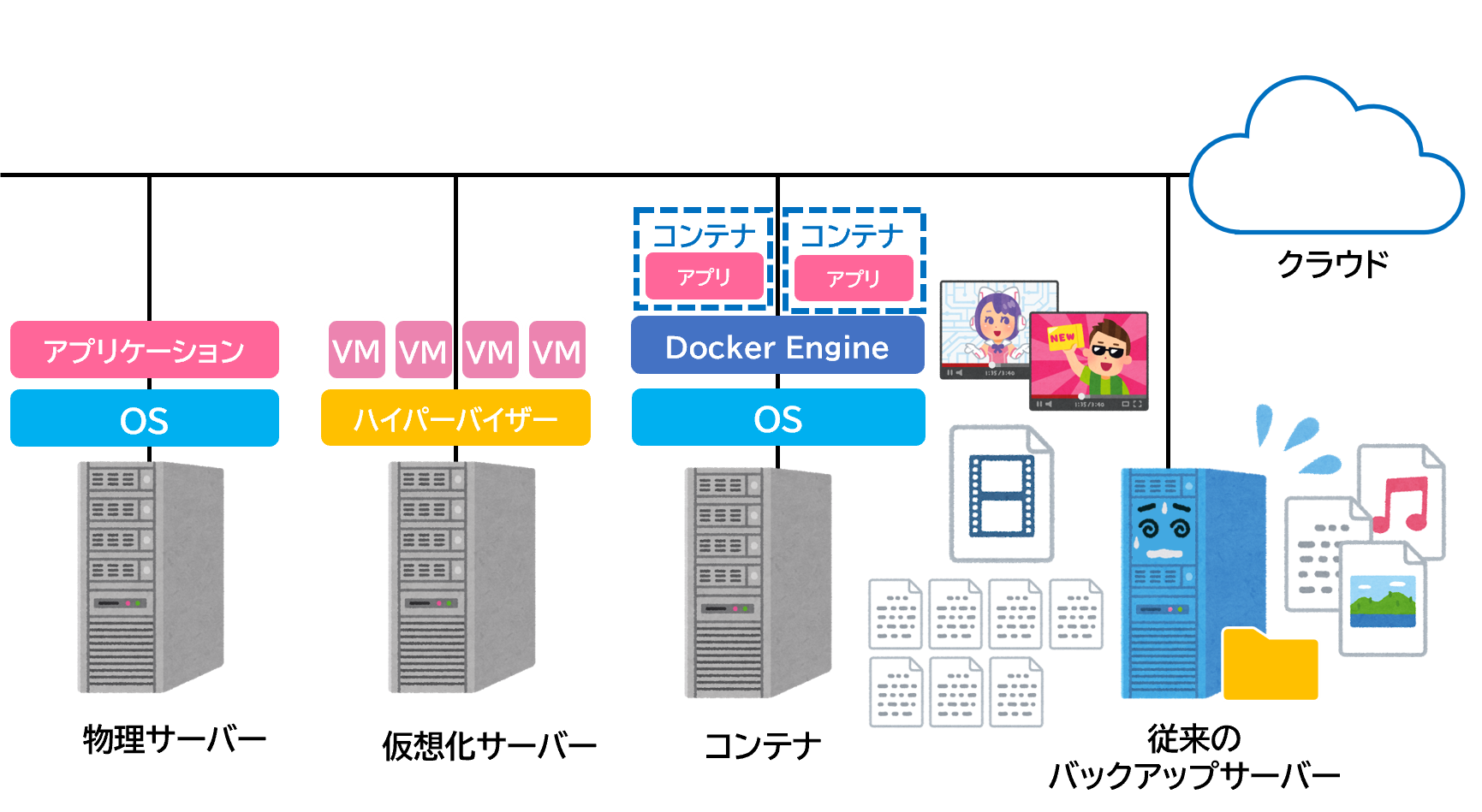

データの増え方の変化とはつまり「データのワークロードの変化」と言っていいじゃろう。時代の進化とともに、今までとデータの出力される環境が変わってきている。今までの環境では物理サーバーや仮想化サーバーがメインであった。

センサーから出力される細かくて無数にあるテキストデータや、ビデオカメラから出力される大きなサイズのデータなど、単純なデータの増加だけではなく、沢山の新しい技術が出てきたことにより、データの性質がそれぞれ異なっている。

そんな異なる性質のデータの急激な増加が原因で、従来のバックアップ構成や方式ではシステムのパフォーマンス計算が難しくなったんじゃ。

従来のやり方ではなぜバックアップのパフォーマンス計算が難しい?

その際に今までのハードウェアではデータを保存する(貯める)ことを優先に考えているので、細かいデータの検索などはあまり得意ではないんじゃ。

結果としてバックアップデータの特定のファイルの検索やリストアなどには時間がかかってしまう。

一般的にアプライアンス製品の基本構成は、キャッシュとしてSSDなどのフラッシュディスクを搭載している事が多い。

これは利用頻度の高いデータや大量のメタ情報、つまり後の検索などに利用するデータをSSDに置くなど、快適にユーザーが利用出来る工夫がされているんじゃ。

アプライアンスは、いろんなことが考えられて最適にチューニングされているんですね。お客様に自信を持って説明できる様にもう少し詳しく教えてください。

それではアプライアンスの種類を詳しくみて行こう。

アプライアンスの種類 スケールアップ型・スケールアウト型

それぞれのメリット・デメリットについてみて行こう。

スケールアップとスケールアウトの違いは分かっておるな?

もし忘れていたらストレージ編基礎勉強のやり直しじゃ。

でもそのサイトぼくも見ました!ストレージの基本から詳しい機能まで解説してあってわかりやすかったな~。 冊子版もあるから読んだことない人はネットワールドに問い合わせて入手するべきですね!

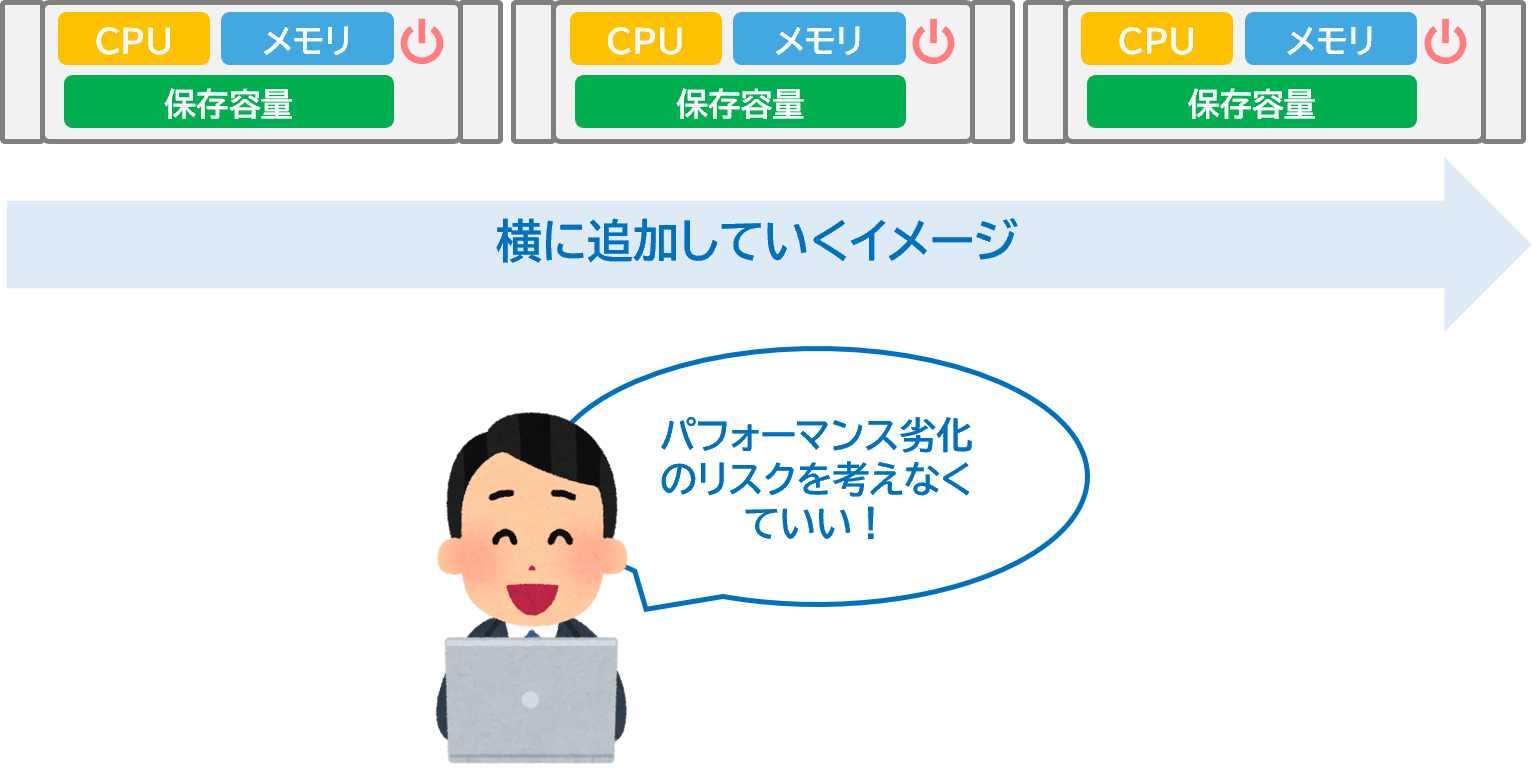

スケールアウト型は、ディスク増設時にパフォーマンスを考える必要がない

スケールアウト型のメリットはなんじゃ?

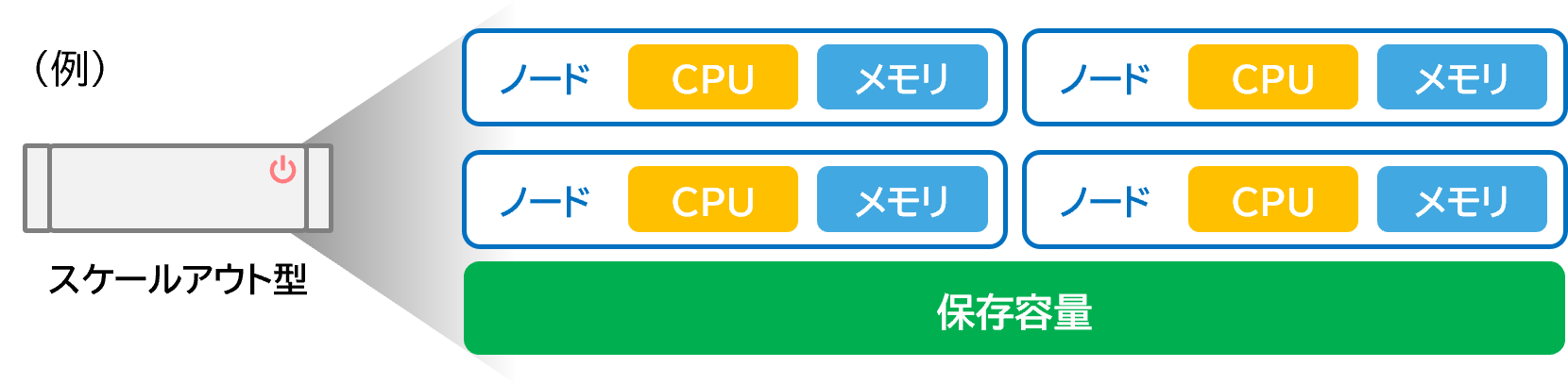

スケールアウト型

ではスケールアップ型はどうじゃ?

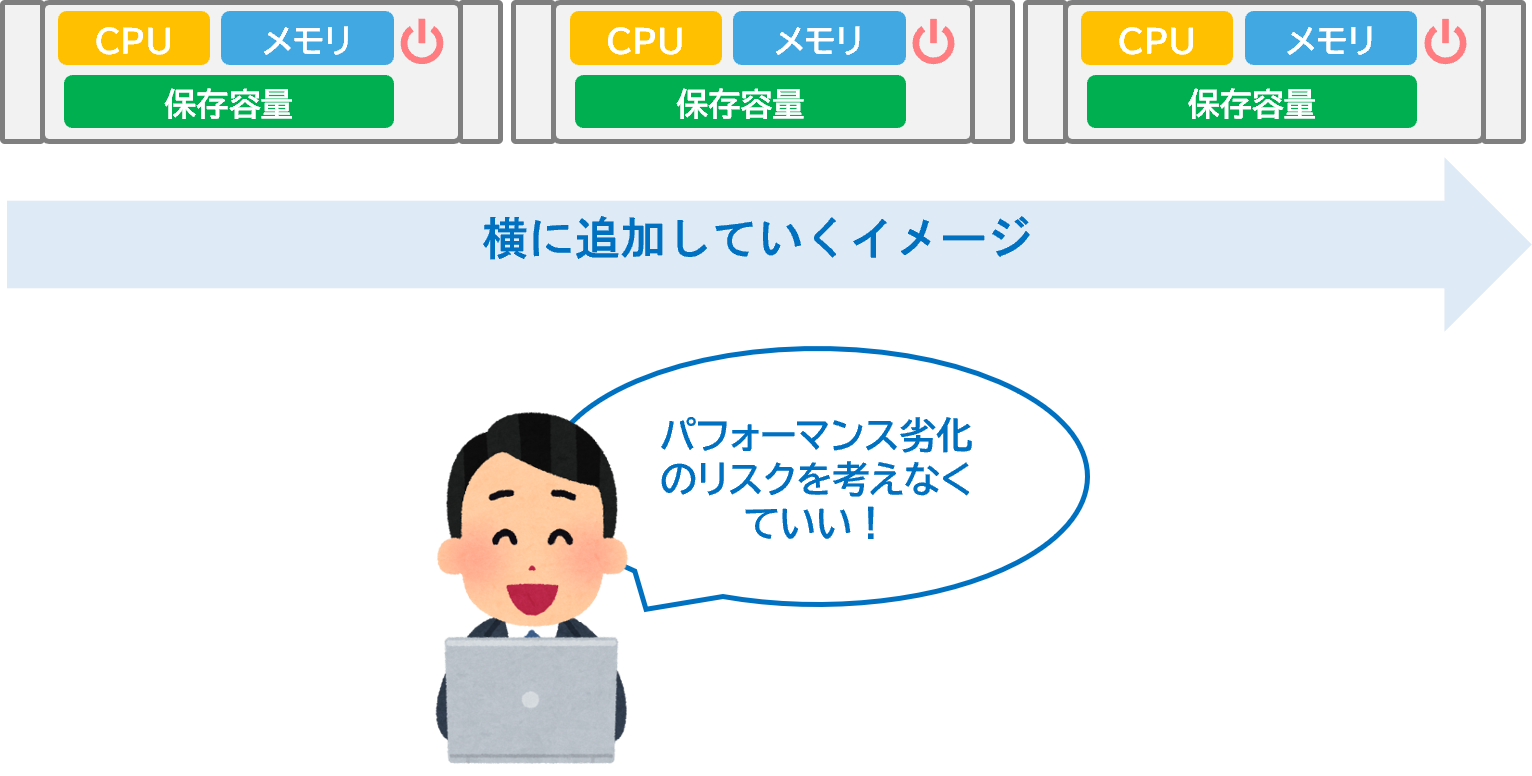

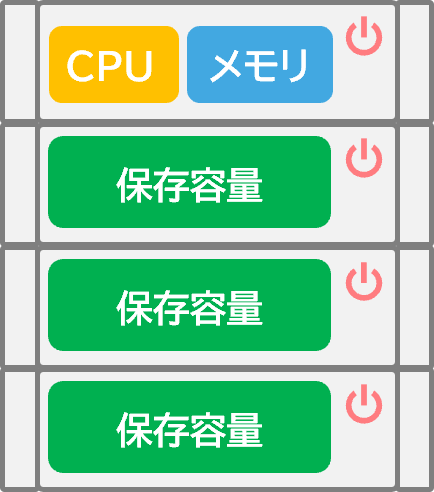

スケールアップ型は、必要なリソースだけ追加してコスト削減できる

状況によって容量だけ足りないけど、CPUやメモリーなどのリソースがまだまだ空いている場合にはストレージ部分だけを増設することで、拡張の際のコストを抑えることができます。(ドヤ)

スケールアップ型

ではCPUやメモリーの処理が足りなくなったらどうするんじゃ?

よって、ある程度余裕をもって交換することをお客様にはおすすめしています。

スケールアウト型のほうがいいのかな ?

実はなんだかその辺がよくわかっていないんです。詳しく教えてください。

スケールアウト型とスケールアップ型、どっちを選ぶべき?

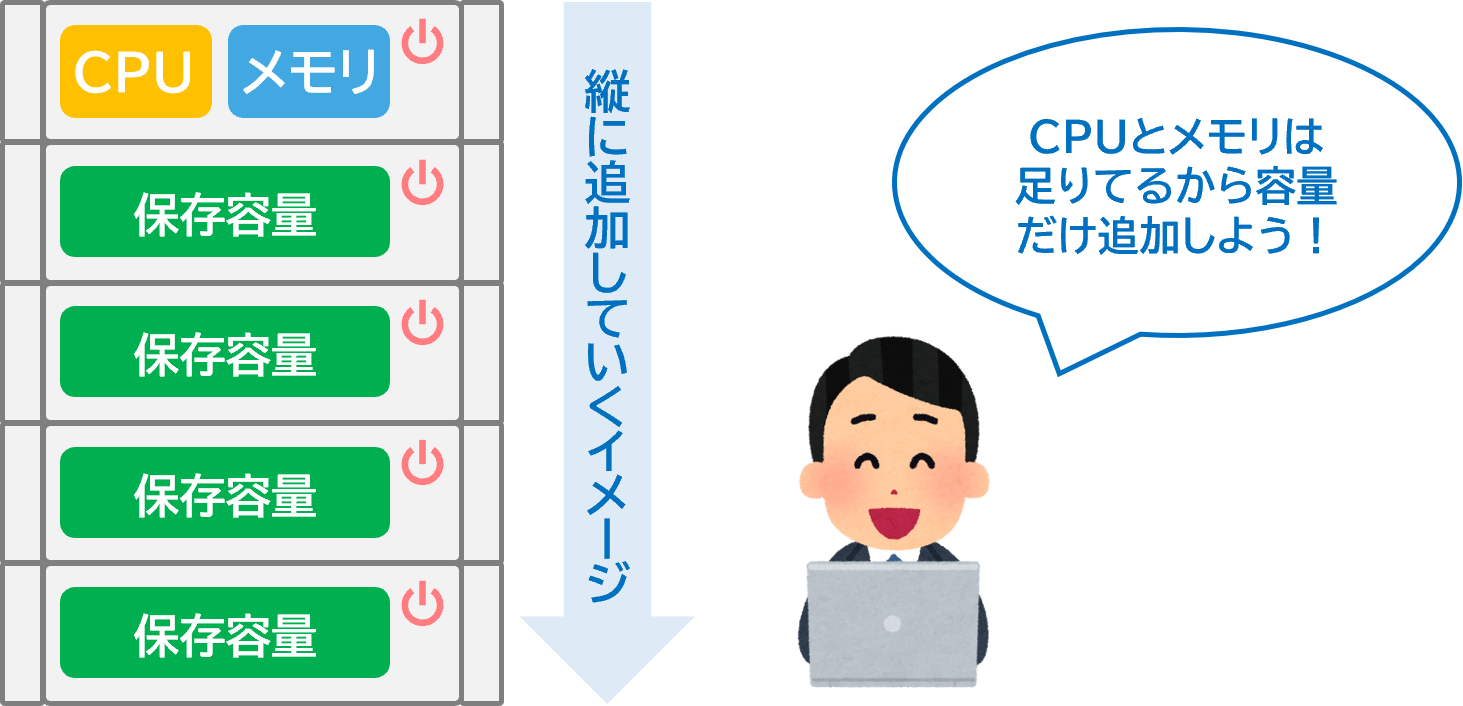

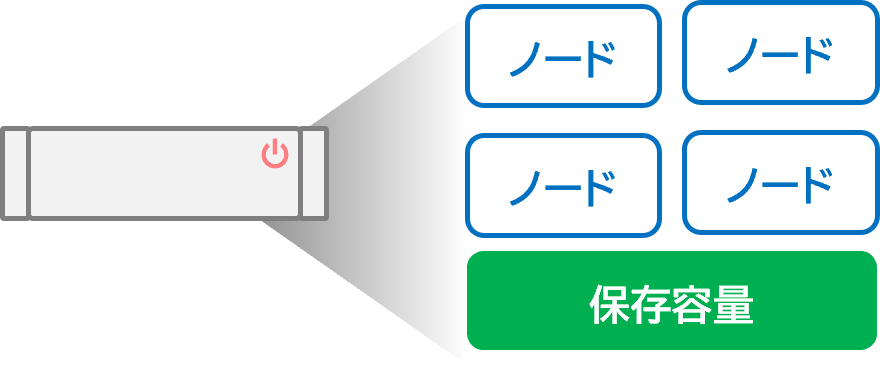

スケールアウト型は、アプライアンスを追加する際に各種制限や最小のノード数などの決まりが多くある。例えば最小3ノードから購入可能などじゃ。

この場合のノードとは、CPUやメモリーが入ったコントローラーと考えてもらっていい。

そうなるとコストがそれなりにかかり、安いタイプでも1,000万円を超える商材がメインとなってくる。このようなコスト面からSMB企業ではスケールアップ型の物が選択されることが多い。

スケールアウト型

先程データが飛躍的に増え続ける中で5年後のデータ容量を見極めるのは難しいと話をしたが、少し容量やパフォーマンスが上位の機種を選択しておくことで、拡張性が広がり、自分で機器を組み上げるよりは、圧倒的に拡張が容易なのも事実である。

スケールアップ型

でもアプライアンスは、どこのメーカーも非常に高価なため、100名以下のSMB企業や地方の支店には向かない気がするんですがどうでしょうか?

確かに過去の事例からすると、特にスケールアウト型のアプライアンスは大企業に入る事が多い。だが各社より拠点向けや小規模事業者向けに、スケールアウトしないエントリーモデルもたくさん出ているぞ。

これは拡張性こそ無いが、HW/SW一括サポートや、システム構築が不要など、アプライアンスならではのメリットが豊富じゃ。

今後データがどのような勢いで急増するか、技術の進歩はどのように変化するかは簡単に予測できない。絶対とは言えないが、企業のデータ容量に応じて、導入されるモデルをざっくり下記のようにも分けるのもありじゃな。(2025年現在)

容量:~4TB

サーバー内蔵ディスクを利用

容量:20TB~2000TB

スケールアップ型

容量:2TB~80TB

エントリーモデル

容量:50TB~

スケールアウト型

- 有事の際にストレージリソースとしての利用

- 冗長性の違い

- REST APIによる開発チームとの連携

- アプライアンス特別ライセンス

ストレージリソースとしての利用

データ復旧方法は大きく2つ!リストアとインスタントリカバリの違い

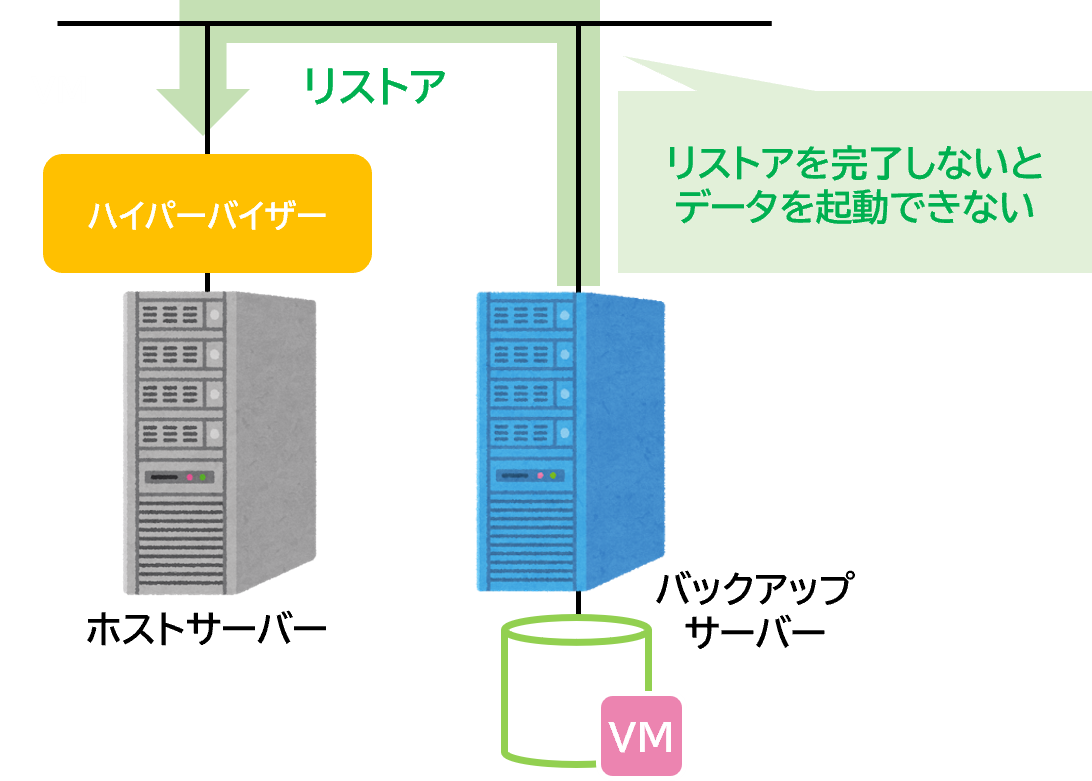

1つ目はデータをホスト側のサーバー側にリストアして利用します。

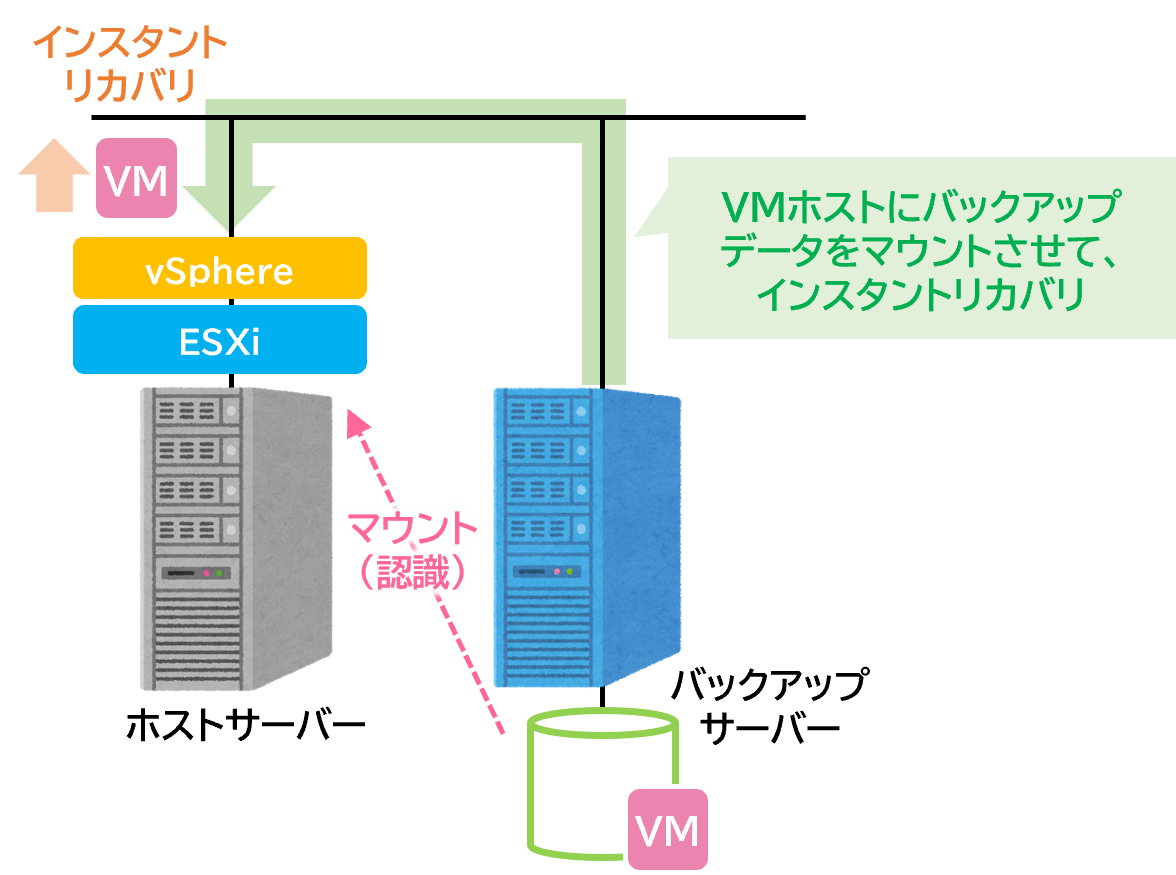

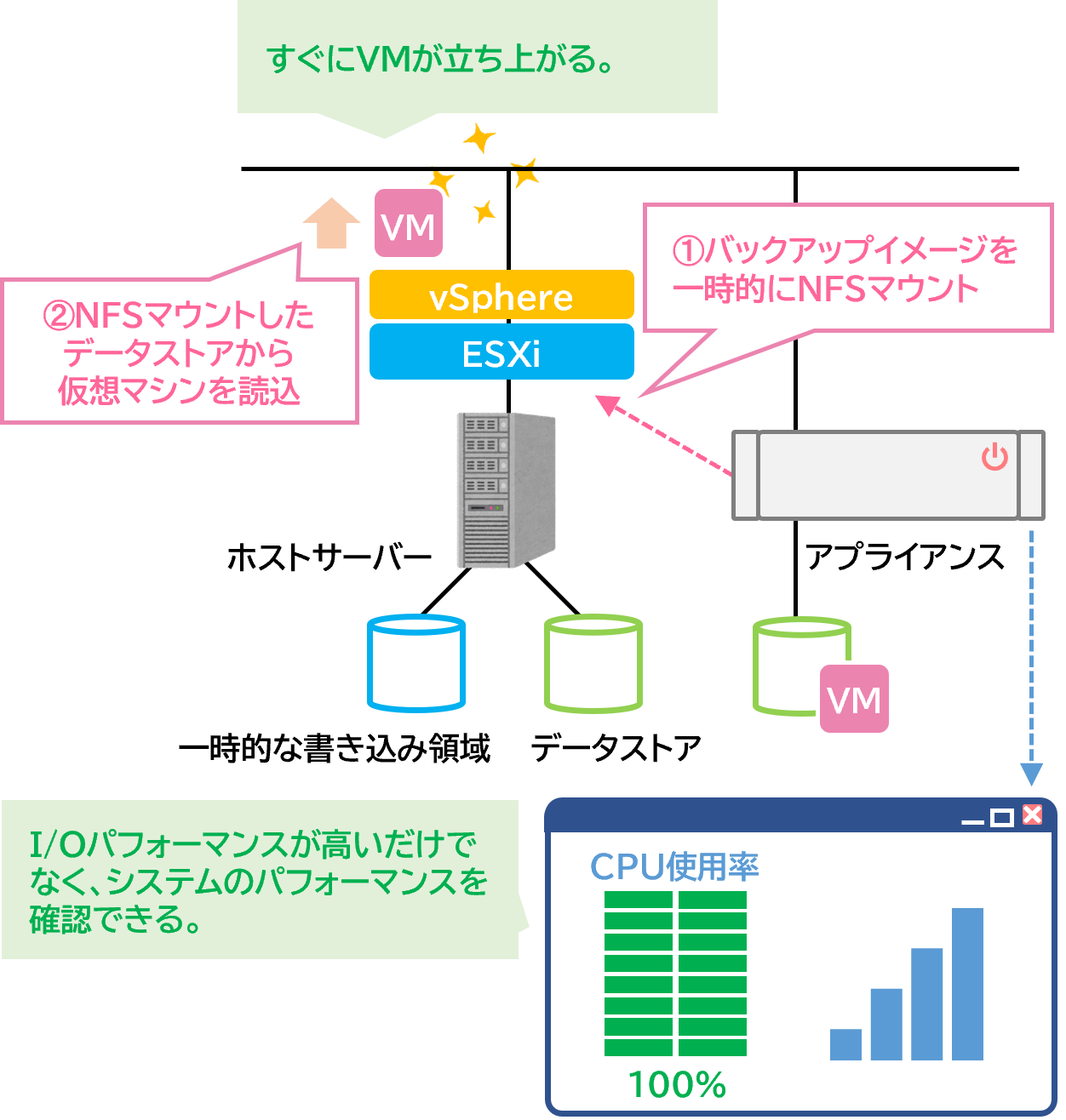

2つ目はバックアップソフトにもよりますが、インスタントリカバリなどの機能があれば、そのままバックアップデータをマウントして利用します。

データの復旧方法その➀

バックアップデータをリストア

データの復旧方法その➁

インスタントリカバリ

リストアとインスタントリカバリの違いを動画の視聴に例えると…

ダウンロード方式

ストリーミング方式

ストリーミング(DLしながら視聴)するかの違いみたいなものですね。

よく勉強しているな。

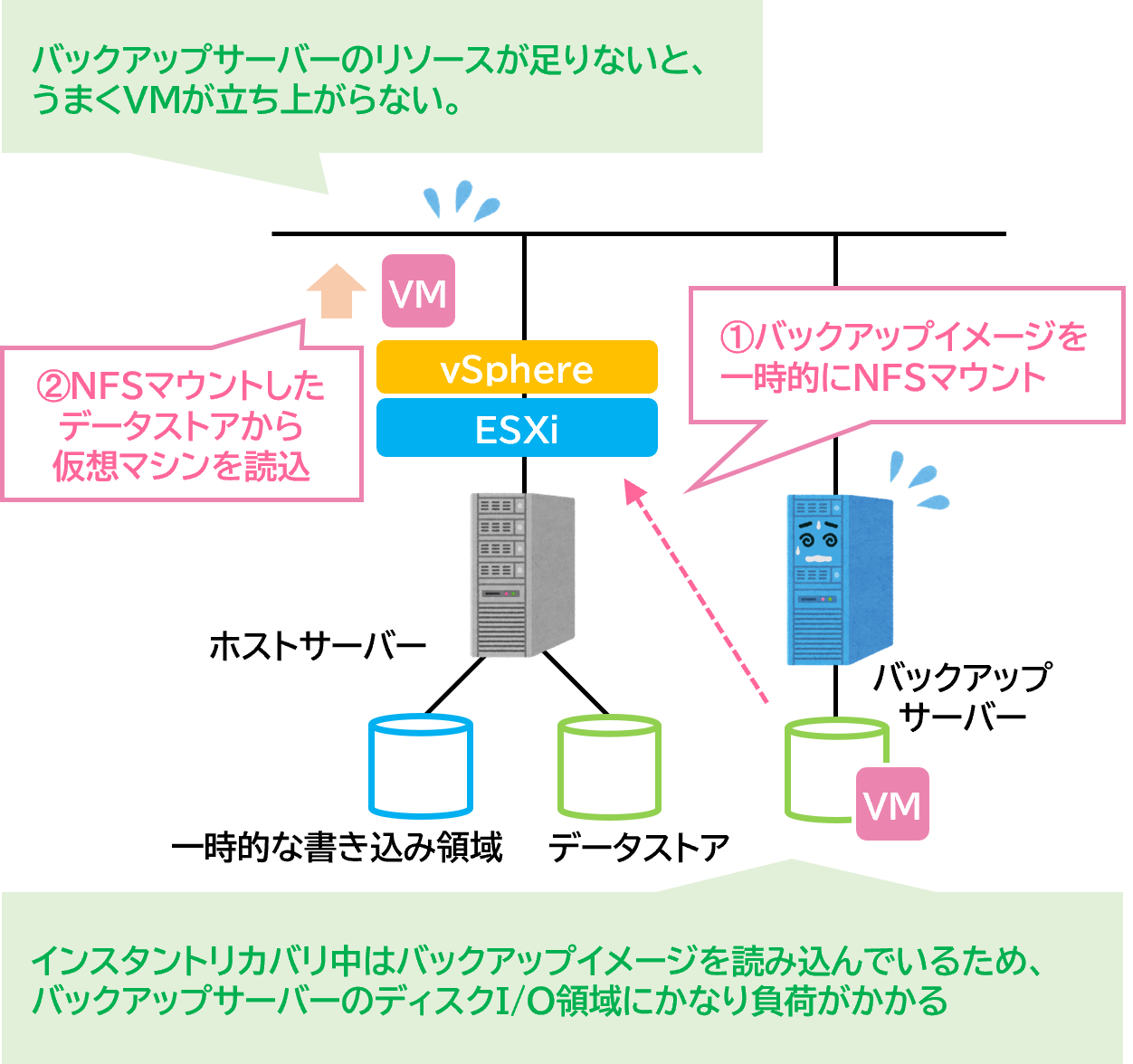

インスタントリカバリの機能を十分発揮するにはハードウェア構成が大事

そもそも今までのバックアップ設計は基本的に“データを保存する場所”ということをメインに考えて、コスト的に安くなる様に設計をしているパターンが多い。

そのために、バックアップソフトウェア側にインスタントリカバリの機能を備えていても、データをマウントして利用する際にデータ転送速度が足りずに、仮想マシンがうまく起動できないなどの問題が起きてしまう事が多い。

安価なバックアップサーバーのインスタントリカバリ

またアプライアンスモデルの場合には管理画面上でソフトウェア的なバックアップの状況監視や設定だけでなく、その機器のつまりハードウェアのパフォーマンス状況をリアルタイムで見れるようになっているものもある。

よって緊急時にはそのハードウェアのパフォーマンス状況を見ながら必要最低限の仮想サーバーのみをインスタントリカバリでマウントして利用することが可能である。

アプライアンスのインスタントリカバリ

アプライアンス型はバックアップソフトがハードと一体になっているのでバックアップサーバーのハードそのものの、パフォーマンス状況も見れるんですね。ここは大きな利点ですね。

使わないともったいない?アプライアンスのリソース問題

でも逆を言えば、普段はそのリソースを利用しないで置いておくということですよね。

インスタントリカバリのためだけにリソースを余分に購入するのは少しもったいないですね。

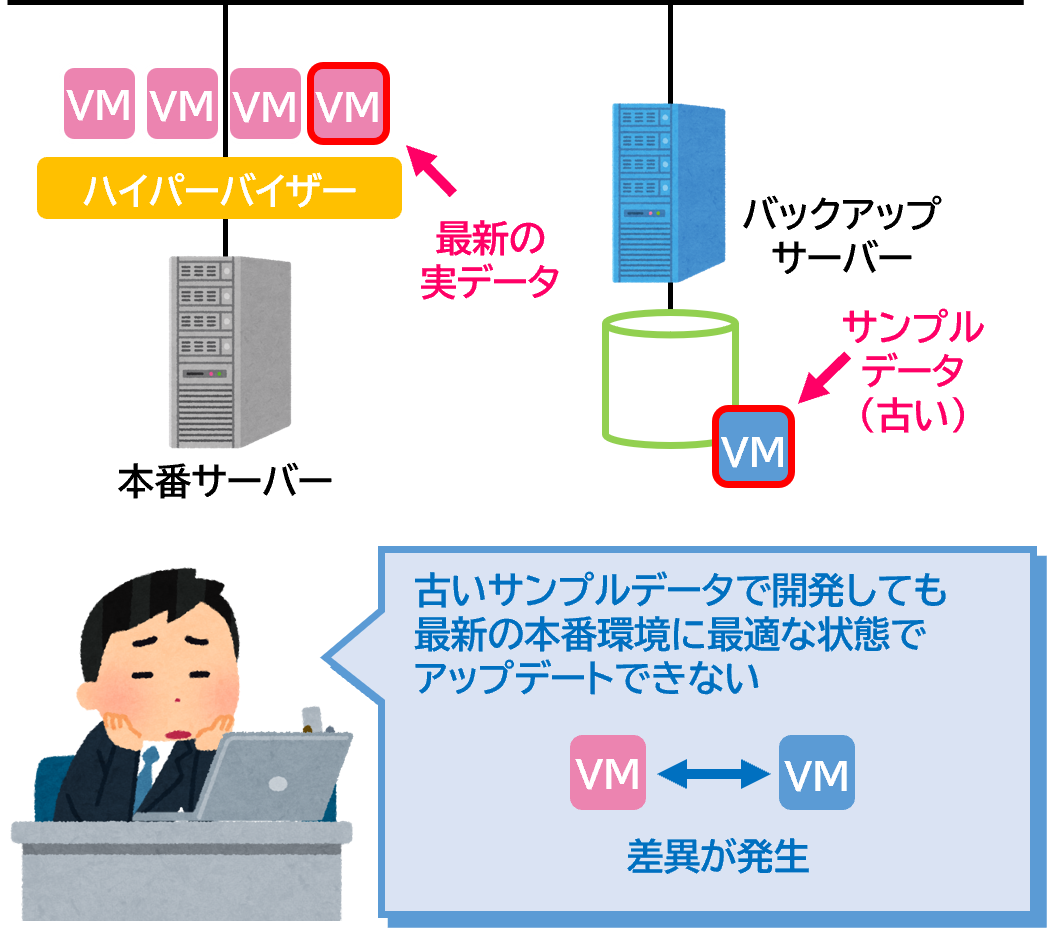

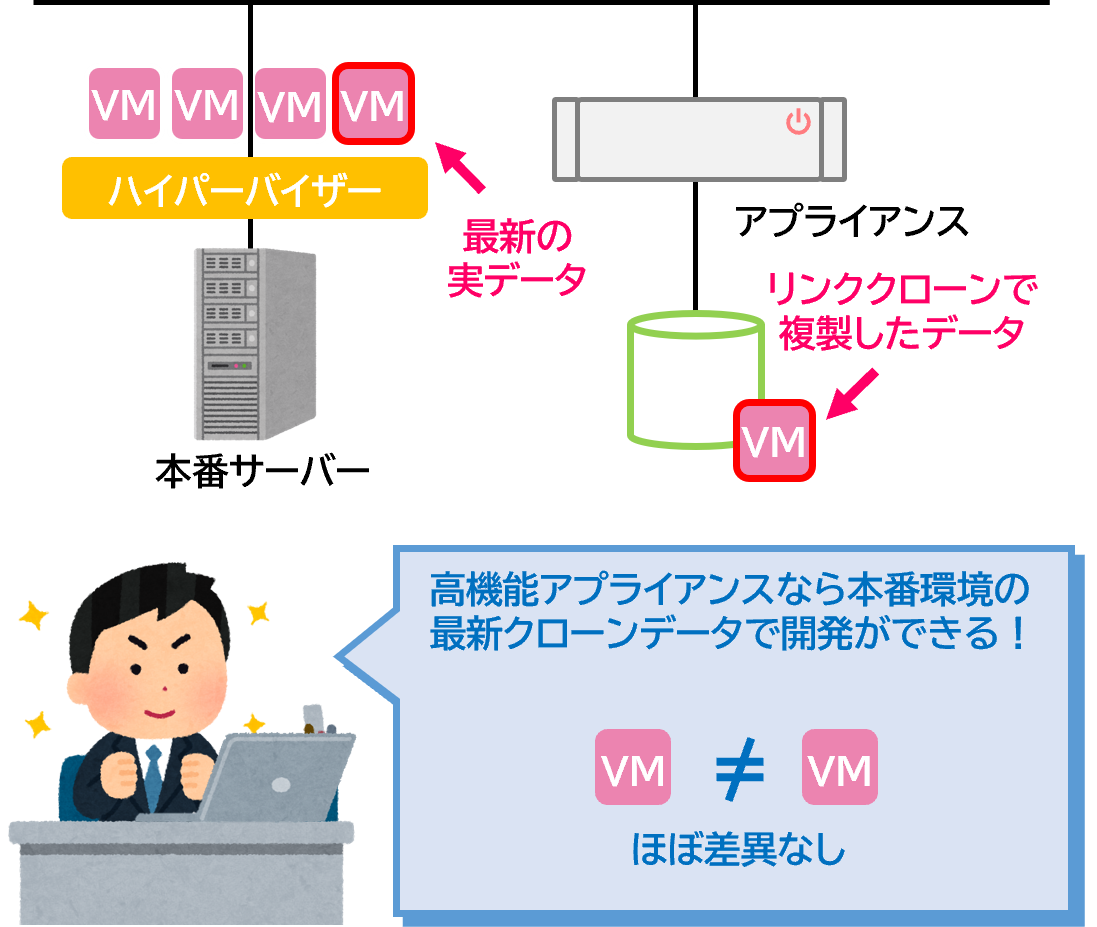

最近ではそのようなコンピュートリソースやバックアップデータを保存しておくだけなのは非常にもったいないので、IoTなどのデータ分析、アプリ開発用のDBなどに再利用する動きがあるんじゃ。

もちろん、オリジナルのバックアップデータには影響がなく、差分のみ別に保存することが出来るのじゃ。

また、リンククローンで作成したデータにマウントを行う際、REST APIで連携できる機能を備えた製品なども多い。

高機能なアプライアンス

REST APIで連携って…!?

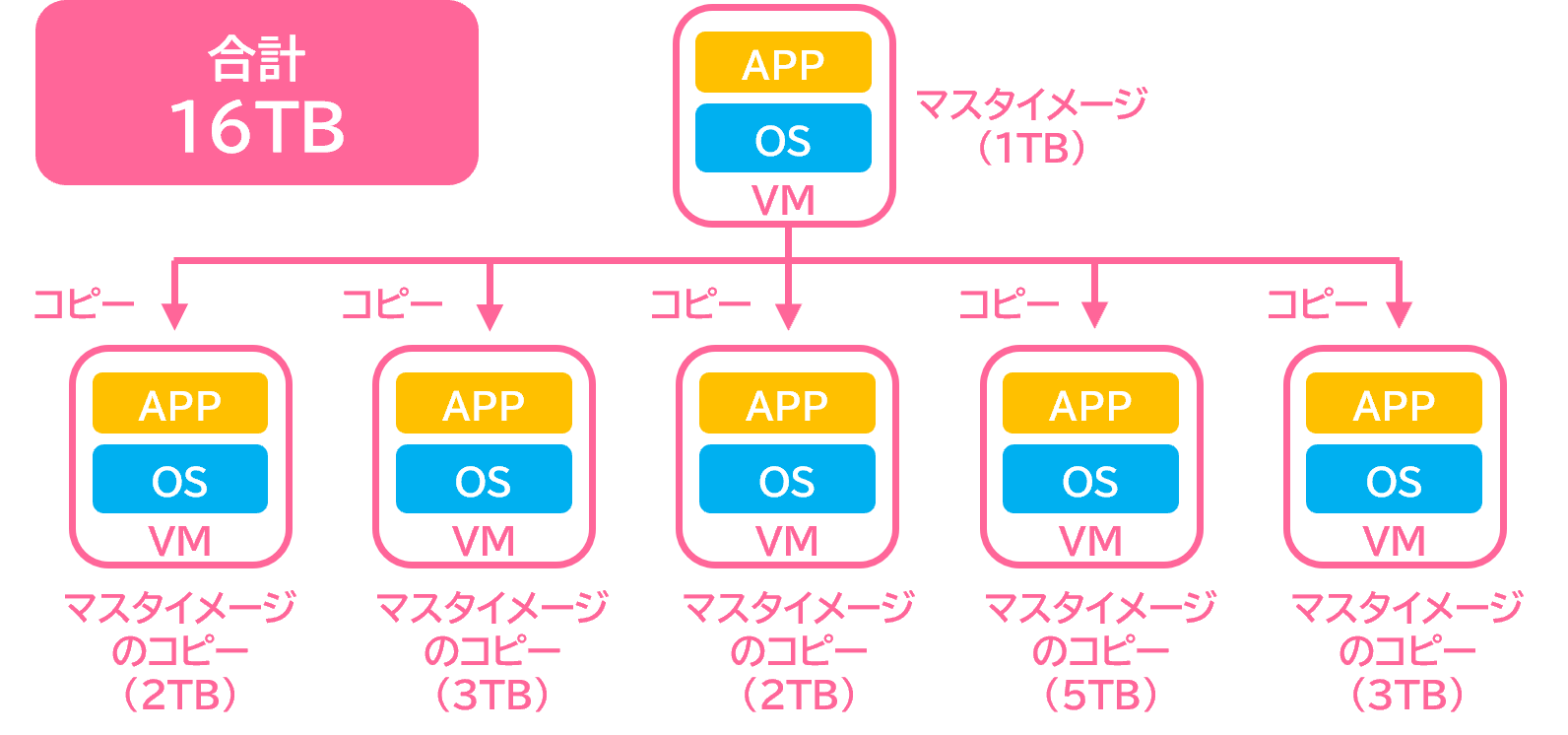

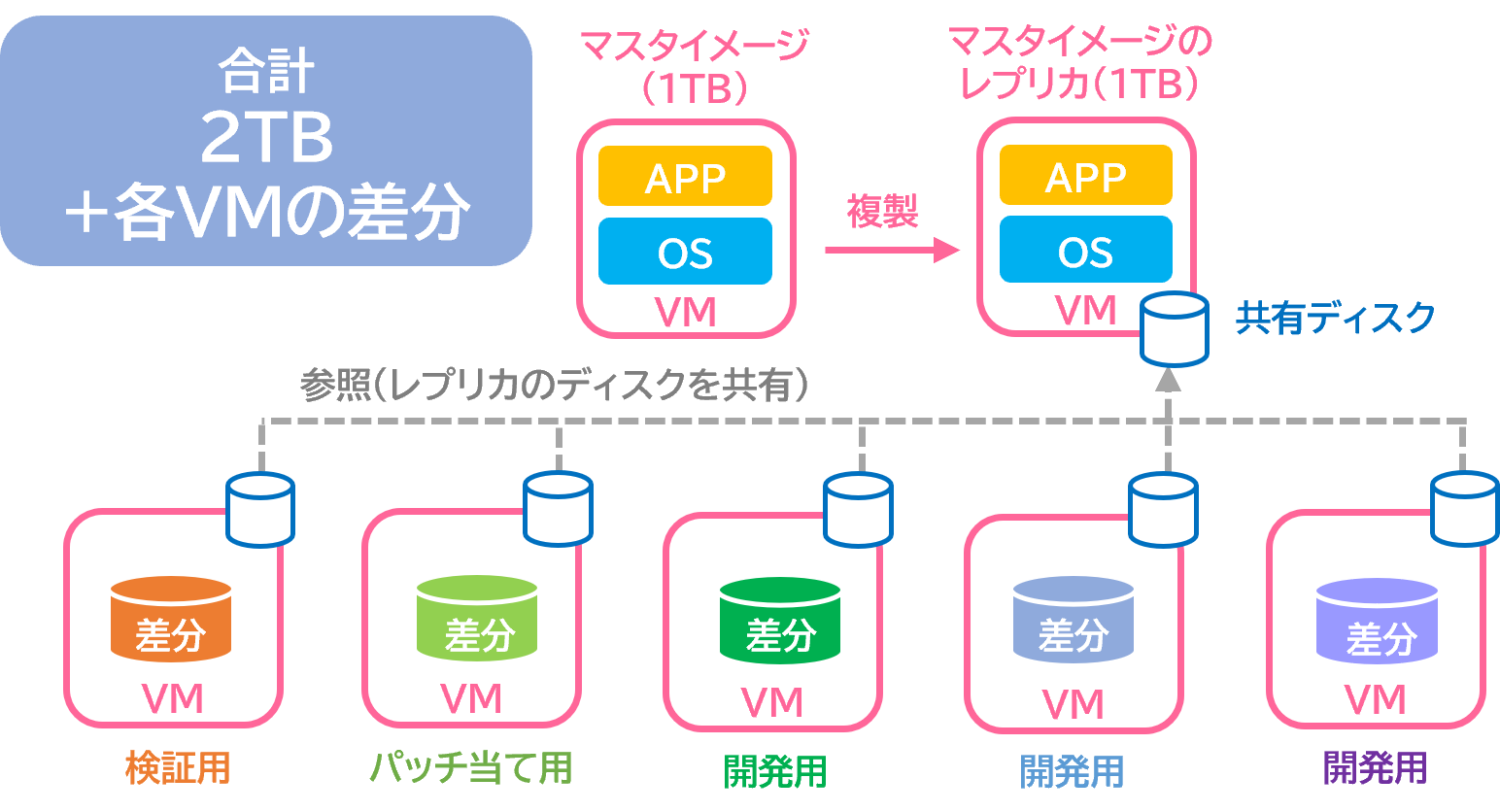

フルクローンとリンククローン

オリジナルのデータにリンクを張って、個々の設定やデータなどの差分だけ保持する方法がリンククローン方式じゃ。そうすることによってオリジナルのバックアップデータは変更せずに、素早くDBのマシンを作成して、検証、バッチ当て、開発などに利用することが可能である。

フルクローン

リンククローン

ギリ理解できました。要はフルクローンのように丸ごとデータ容量を増やさずに、簡単に素早くテスト環境を作れるということですね。

まあ良しとしよう。

最近よくお客様から聞かれますが正直猛ダッシュで逃げて帰ってきます。

まったくわかりません…

今日はアプリケーション開発の話をすると時間が足りないので、かいつまんで説明しよう。

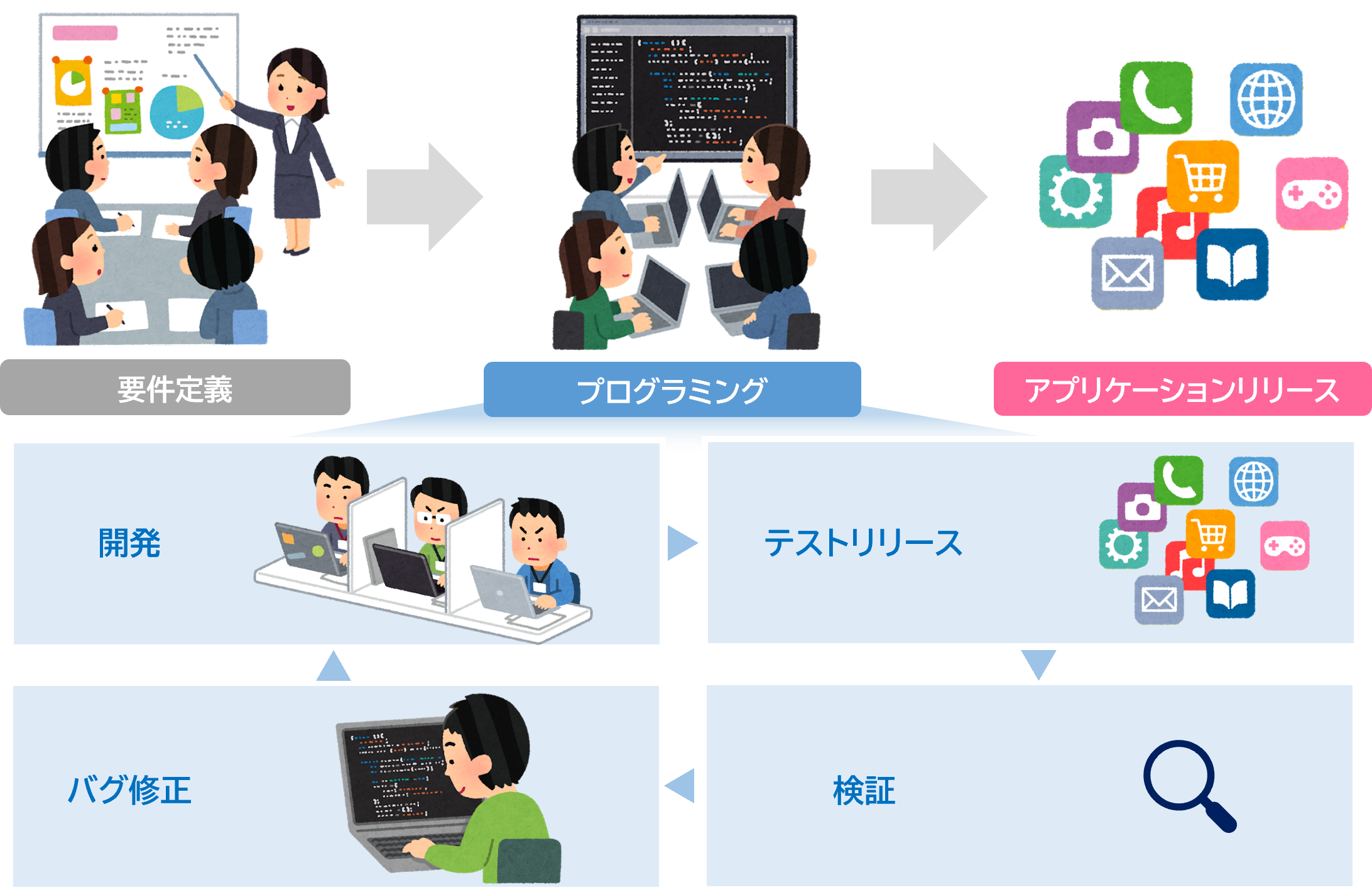

REST API連携

通常はざっくり大きく3つの工程からなる。要件定義→プログラミング→アプリケーションリリースだ。プログラミングは通常複数人でコードを書いたり、機能をパーツごとに分けて開発していく。

その工程の中で、開発→テストリリース→検証→バグ修正を何回も繰り返すんじゃ。その際にテストリリースで非常に手間になる工程がいくつかあるんじゃ。

イメージはこんな感じじゃ。

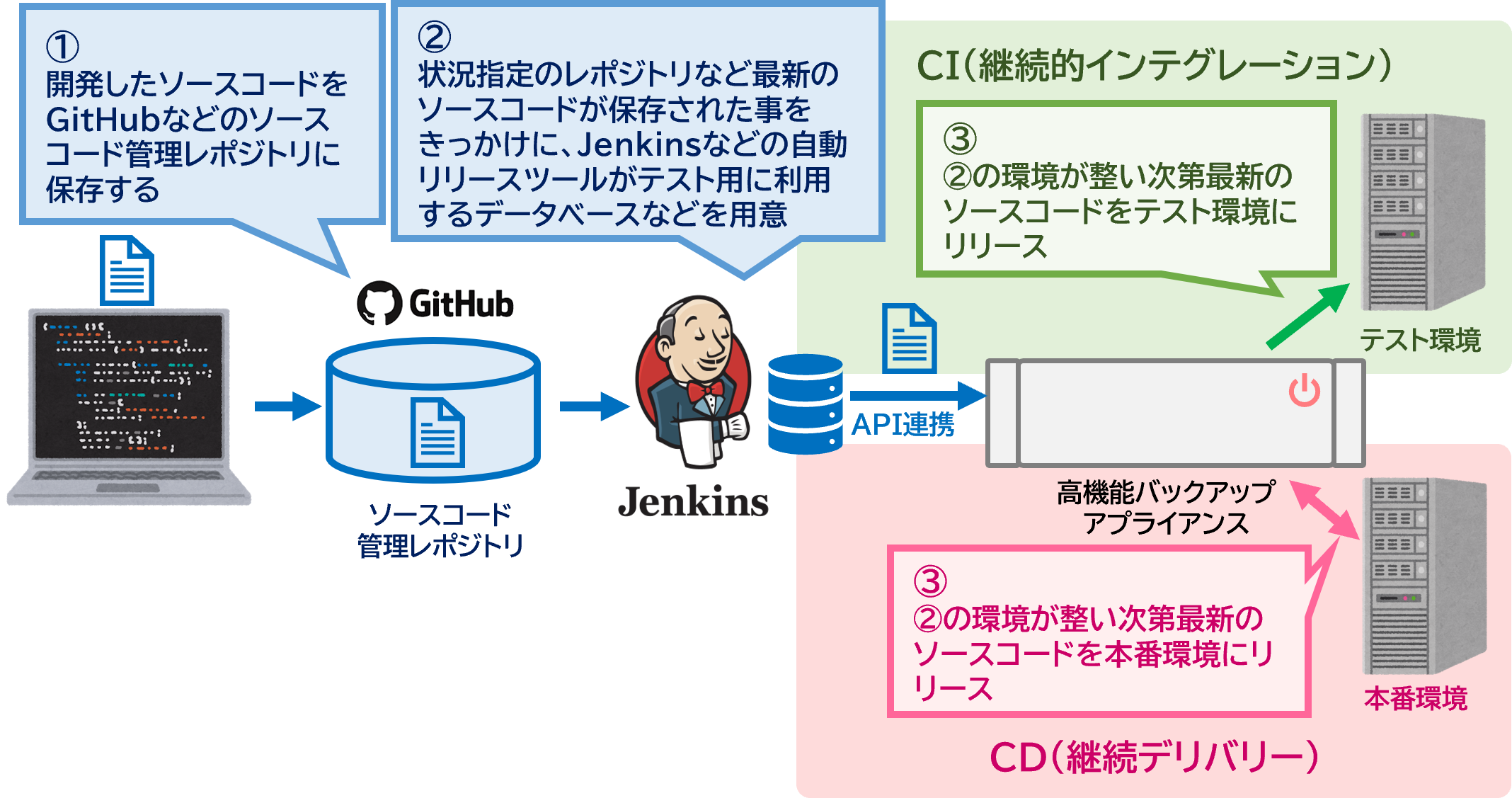

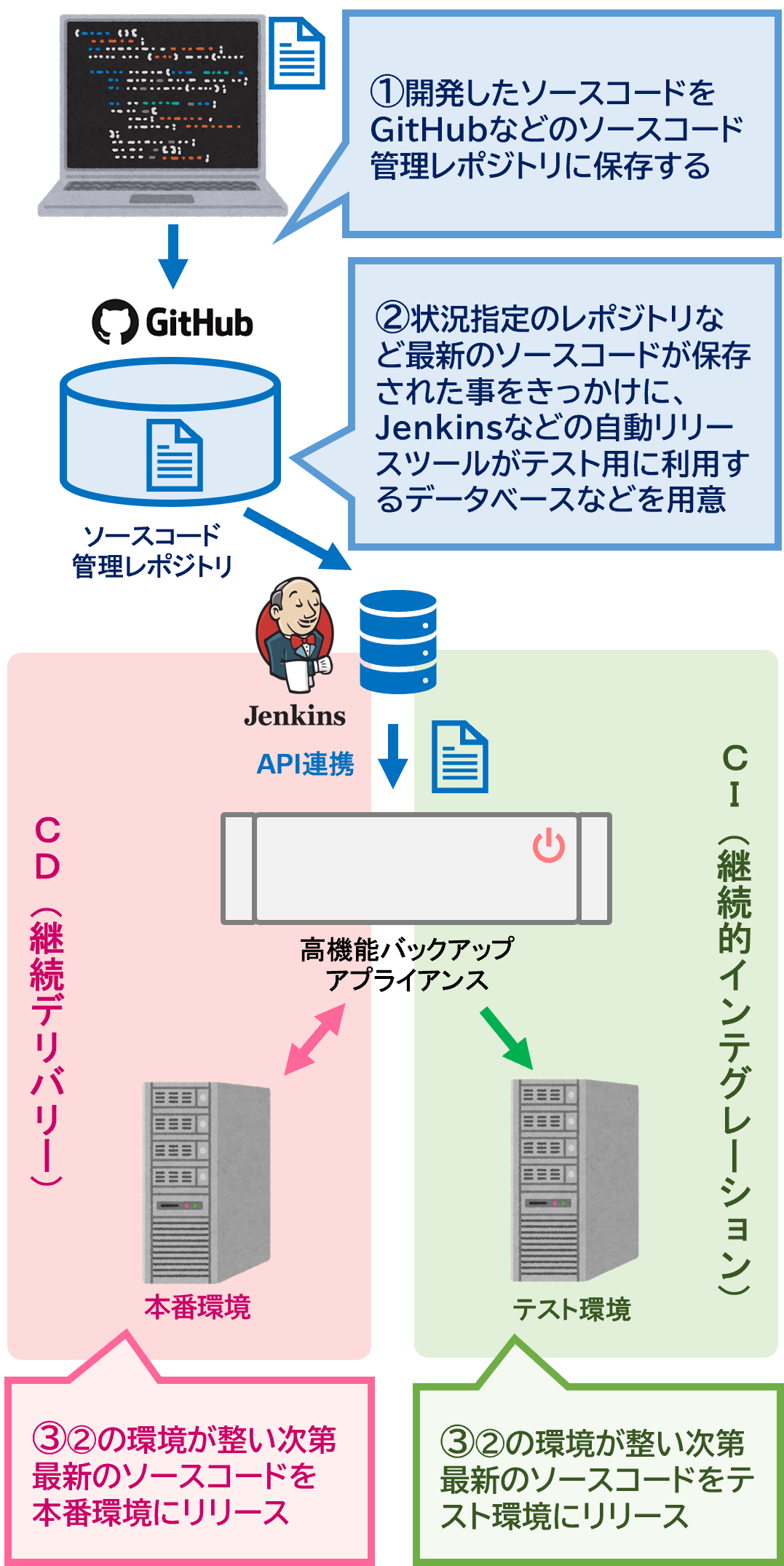

DevOpsに役立つ!REST API連携による自動化

Jenkinsから指令を受けたバックアップアプライアンスが最新のデータベースなどを用意するんじゃ。最近はこのような開発方法をDevOpsという。

DevOps

DevOpsとは、開発チーム(Development)と運用チーム(Operations)が連携し、開発・運用システムによってビジネスの価値を高め、その価値をより確実かつ迅速にエンドユーザーに提供し続ける概念を指す。

その際にデータをためているアプライアンスなどは非常に重要な役目となり、

APIなどの連携が求められるんじゃ。

でもこのようなデータの再活用を考える企業も最近では多くなってきたから、バックアップ機器もアプライアンス型で、中でもパフォーマンスが出るものとしてスケールアウト型の需要が増えているというわけですね。

だから最近は多少値段が高くてもトータルコストを考えて高機能アプライアンスモデルが売れているんじゃ。では次に「冗長性」についてみていこう!

バックアップシステムの冗長性

スケールアップ型とスケールアウト型の違い

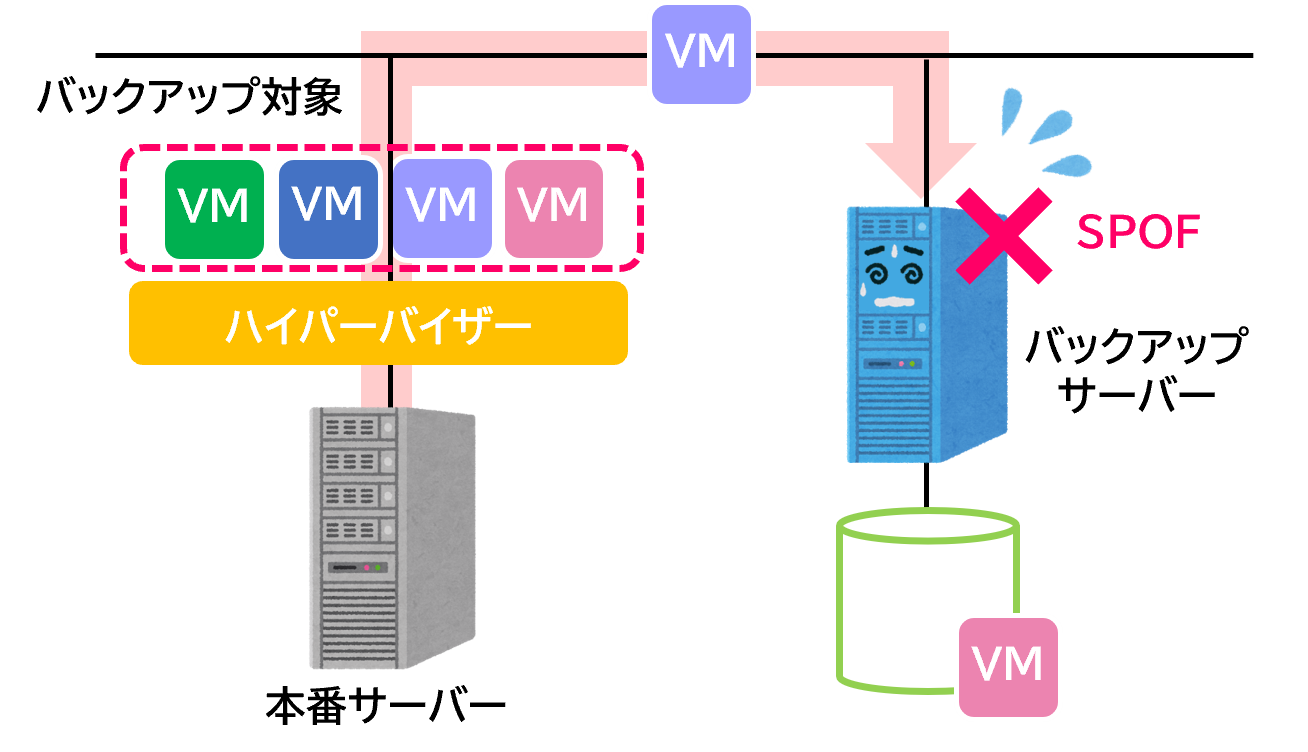

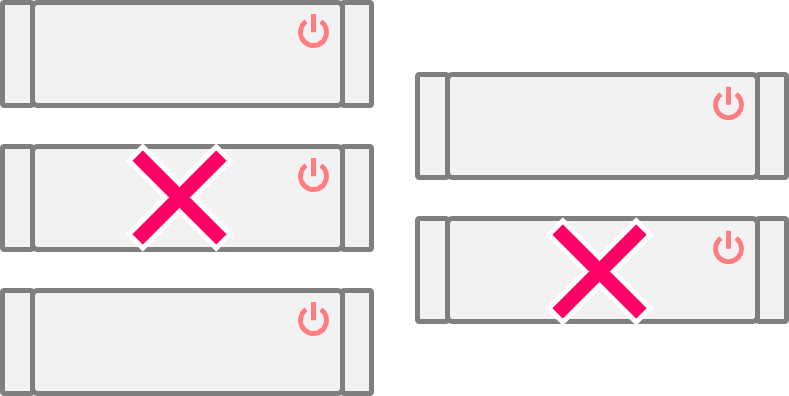

例えば、今までのバックアップ方式だと、基本的にバックアップサーバーやデータ保存をするストレージなどでは一箇所でも壊れるとバックアップ全体が止まってしまう事がよくあった。

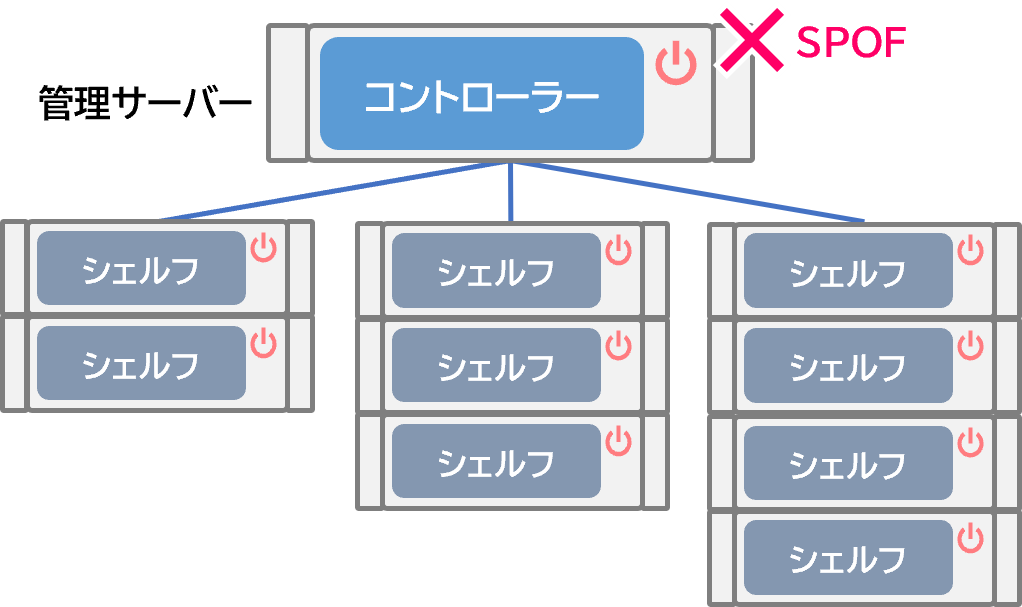

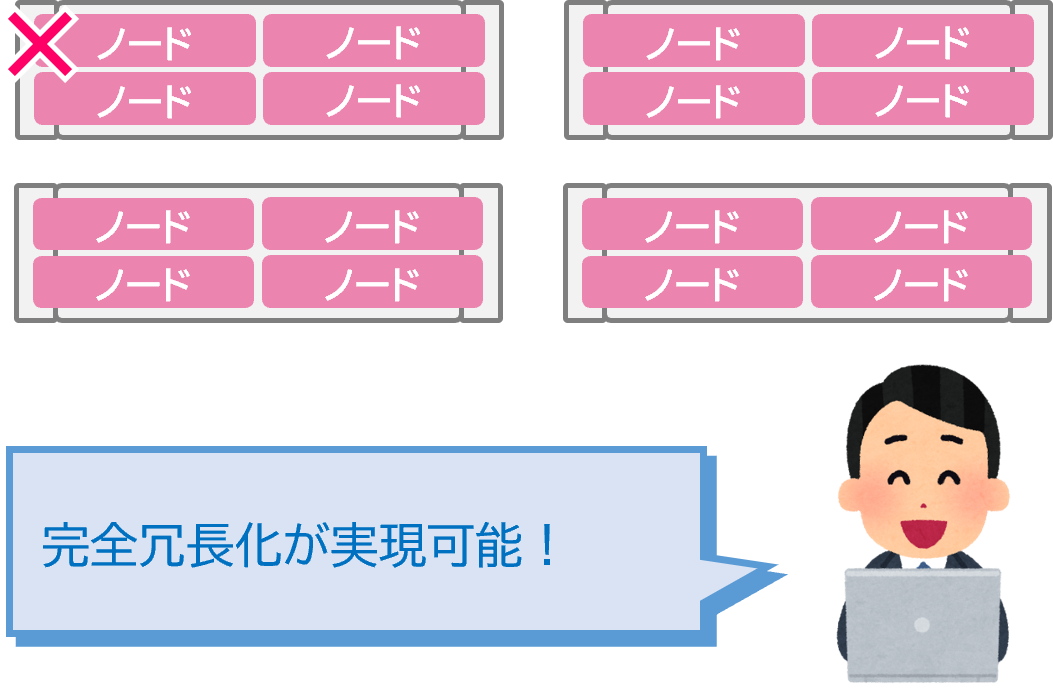

SPOFを防ぐには冗長化が必要だが、今までの形式では通常のサーバーを利用しているために、どうしてもバックアップサーバーを冗長化するのはコストや複雑性の問題から難しかった。従来のスケールアップ型ではバックアップサーバーが冗長化されているものが少ないが、スケールアウト型は障害に対していろんな対策がされている。

スケールアウト型の場合にはサーバーが複数あるので、例えば4ノード中1ノード壊れても、残りの3ノードなどでは縮退運転をしてバックアップ運用を止めないなどが可能になる。また止まらないだけでなく、復旧に関してもメリットは大きい。

スケールアップ型

SPOFが発生するとバックアップが止まる

スケールアウト型

1ノード壊れてもバックアップは止まらない

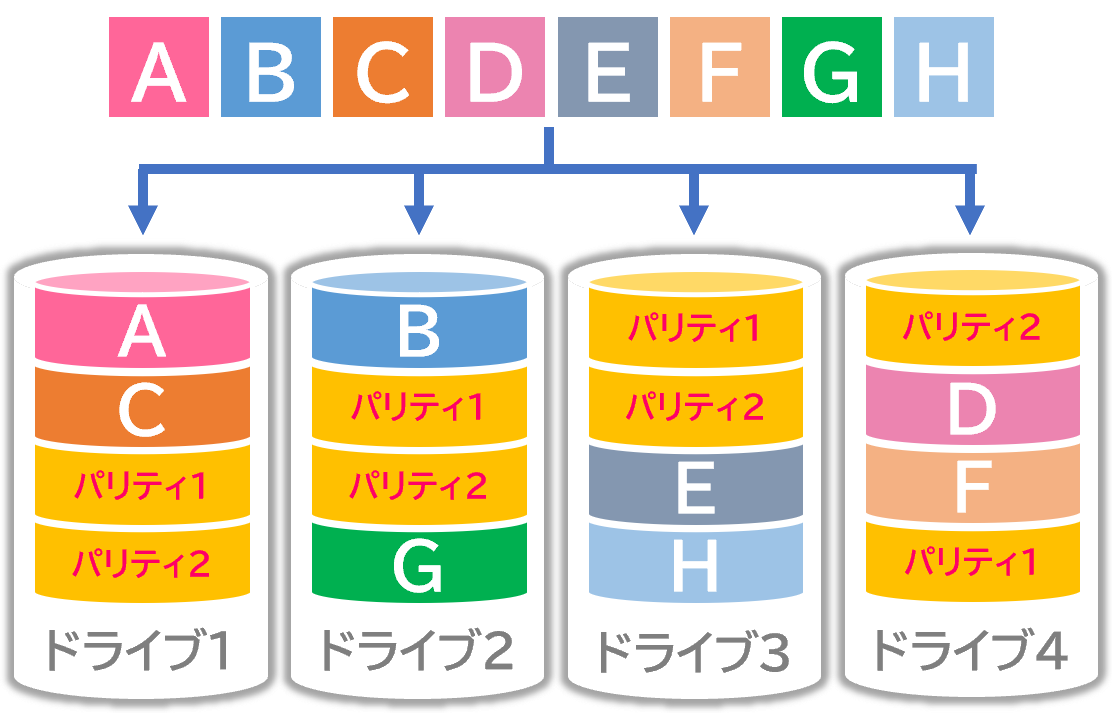

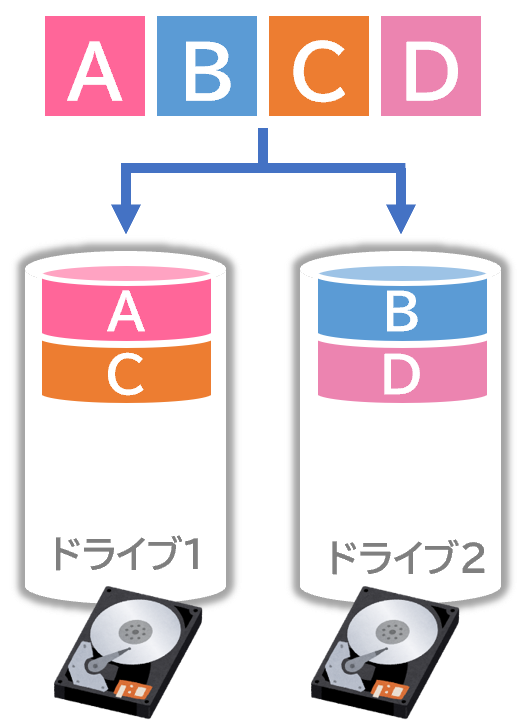

RAIDじゃだめ?大規模環境のディスク障害に備えたイレ―ジャーコーディング

RAID

RAIDは、複数のドライブを組み合わせて、仮想的な1つのドライブとして運用し、信頼性や性能を向上させる技術。バックアップ容量に対し多くのハードディスクが物理的に必要になる。

RAID5(パリティレイド)

パリティによって1本までの障害はデータ復元可能。

RAID6(ダブルパリティレイド)

パリティによって2本までの障害はデータ復元可能。

RAID構成したディスクが故障した時、リビルド(自動で復元)できるように予備のディスクも必要になる。

※RAIDの詳細は、「ストレージを最初に学ぶ人が読むサイト!」で解説!

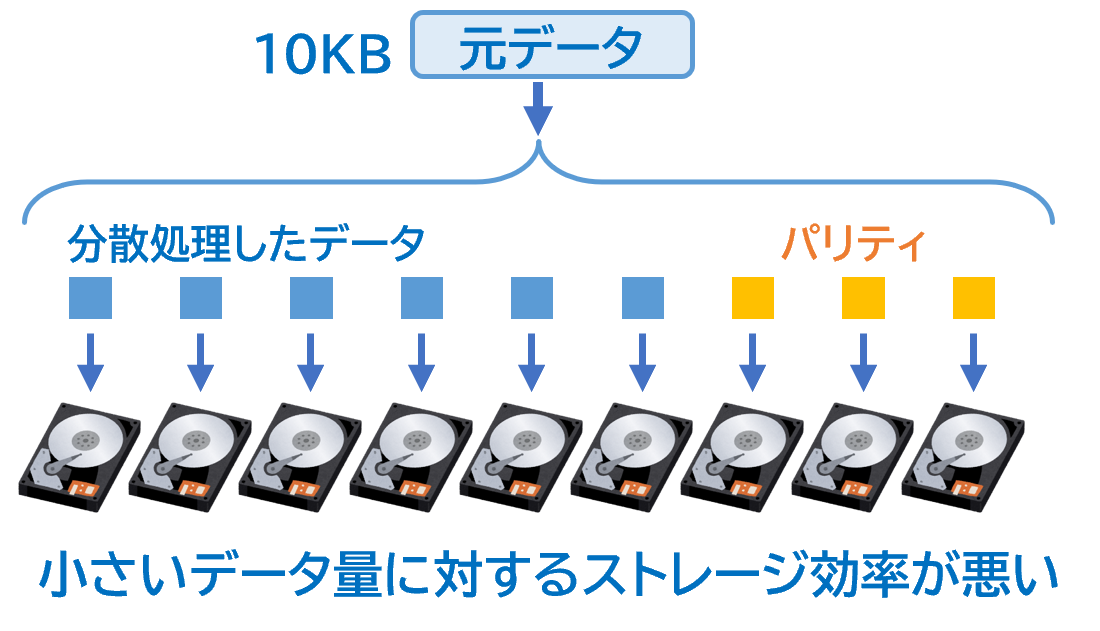

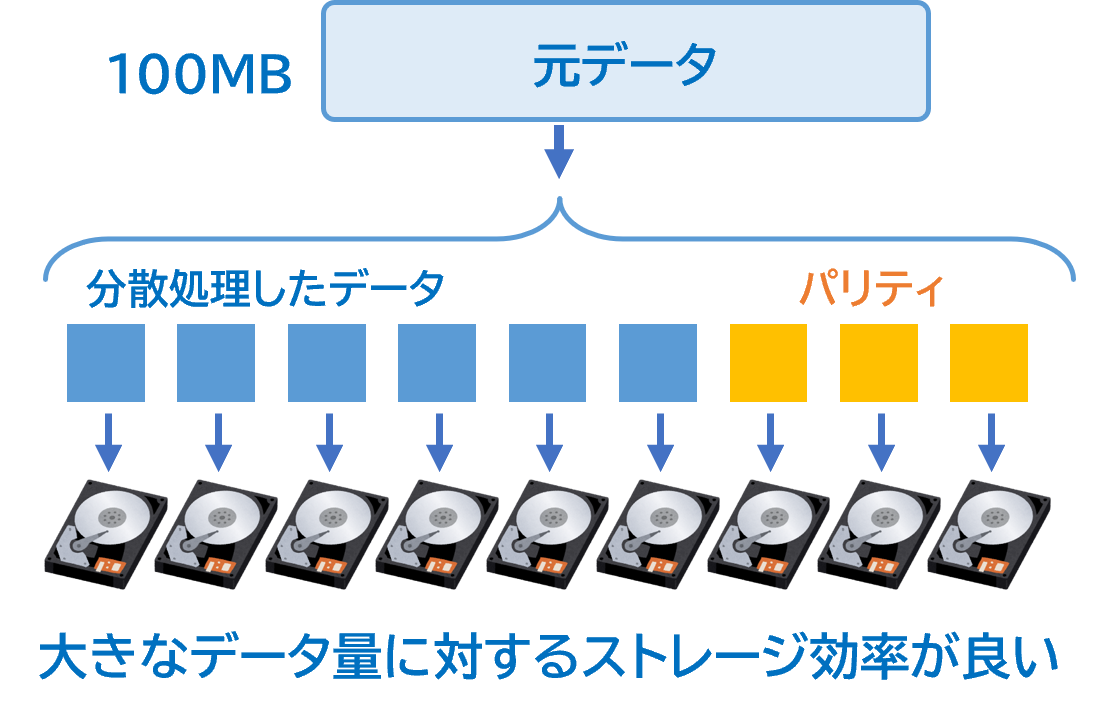

数年前までHDDは大きくても1TB程度だったが、最近はデータ量の増加に伴い、 HDDのサイズも20TBなど大型化している。

HDDのサイズが大きいとRAIDはよくないのでしょうか?

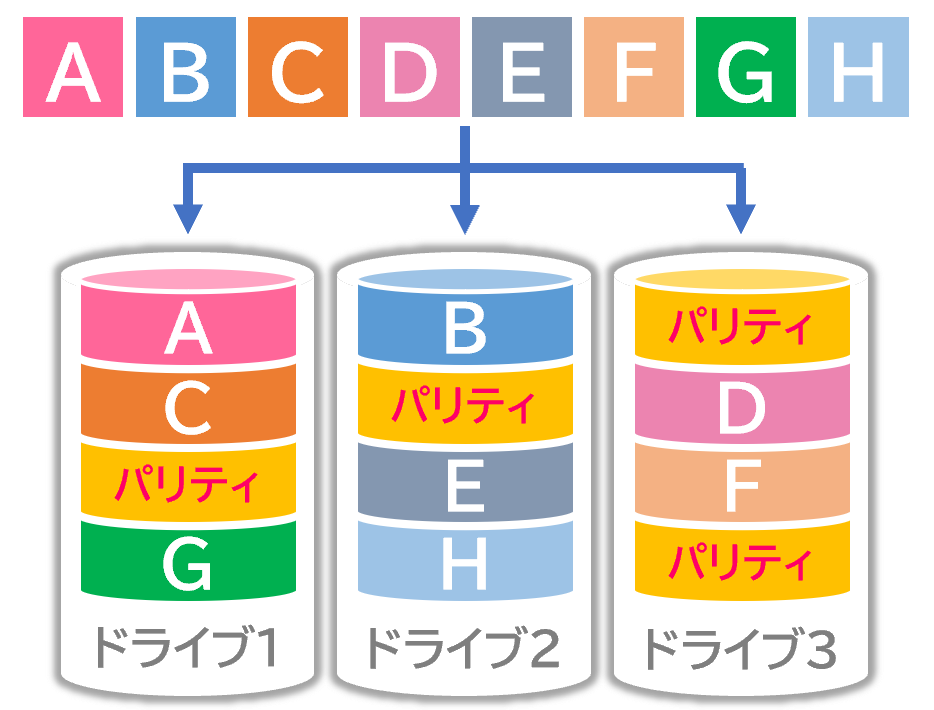

こうすることで、冗長部分のサブセットから元のデータを再構築することができる。

これにより、最近のスケールアウト型のアプライアンスではイレージャーコーディングなどを利用しているためにディスクの復旧が速いことも大きなメリットじゃ。

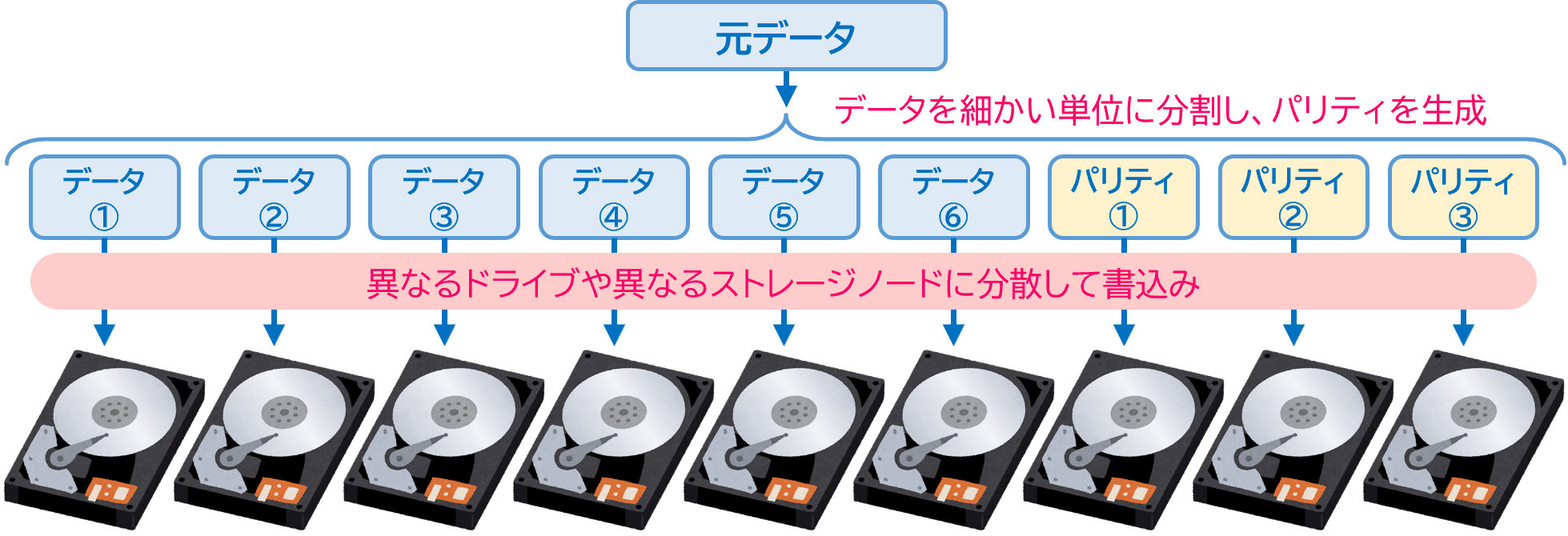

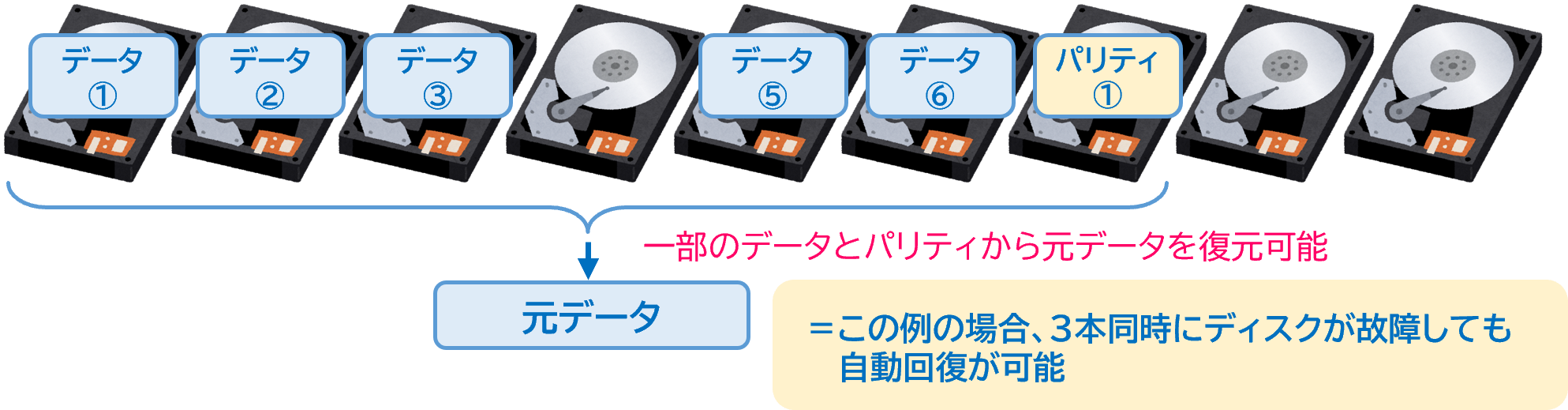

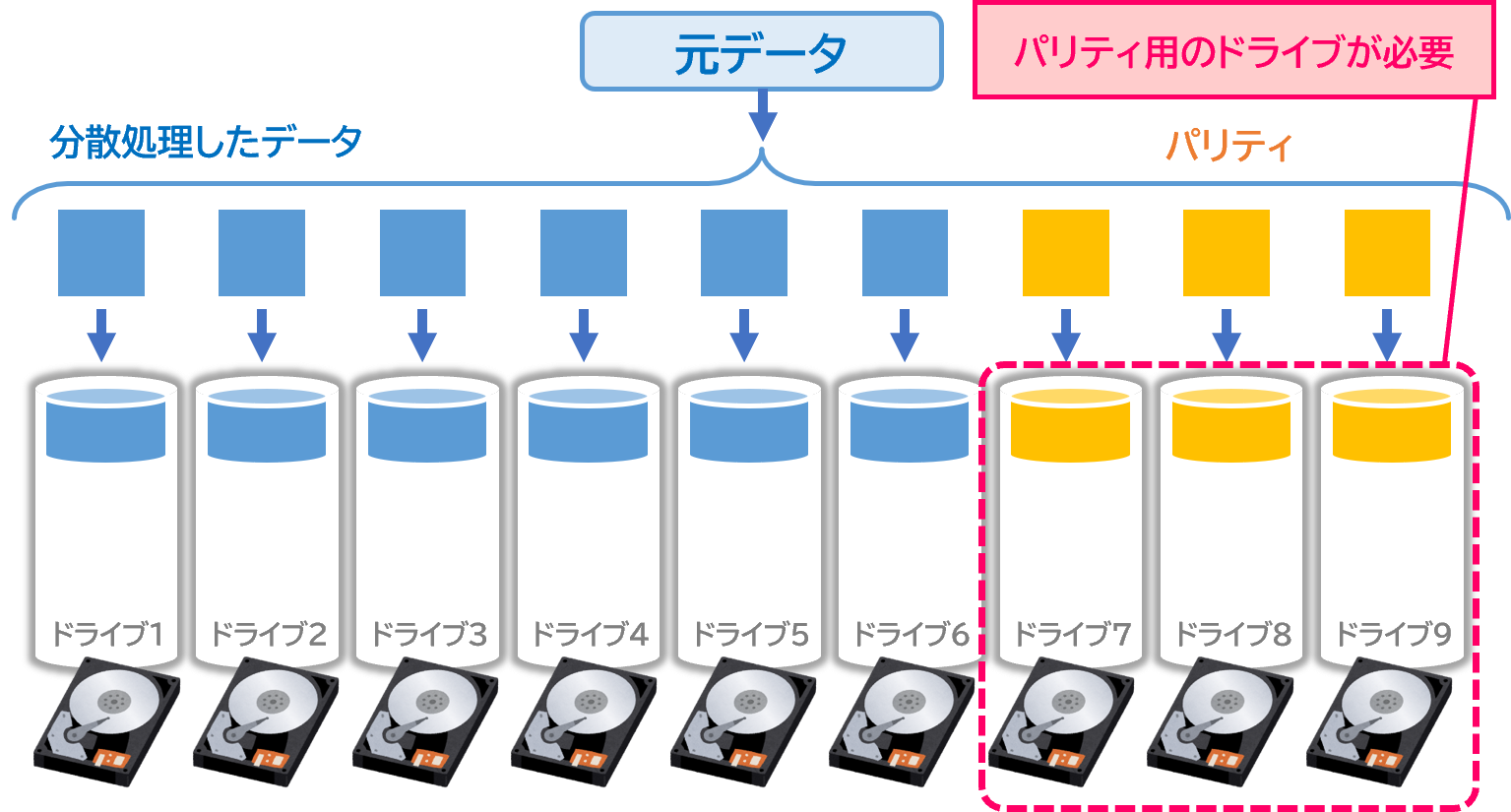

イレージャーコーディング

イレージャーコーディングは数学的関数を使用し、一連のデータをあらかじめ冗長性を含む形式に変換する技術。データを複数の細かな塊に分割し、それぞれのパリティを別々に保存することで、複数台のディスクやノードが故障しても復元が可能です。

書込み時

読出し時

ただしイレージャーコーディングにも弱点はある…

そもそも少数のディスクでは組めないデメリットがある。

つまり、どうしてもシステムが大規模になってしまう。だからアプライアンスでも小規模事業者向けのエントリーモデルなどはRAIDをあえて利用しているモデルも多数残っている。

イレージャーコーディングはデータごとに符号化・自動回復をオブジェクトごとに行い、かつデータを細かく分散処理するために、高速処理が苦手じゃ。

よってプライマリストレージなどでは高速処理が必要なために、RAIDを利用している製品が多いのもそのためじゃ。

またRAID 0(ストライピング)のようにHDDを複数台つないでスループット性能を向上することもできないデメリットもある。

RAID 0(ストライピング)

データを複数のドライブに分散させて書き込むことで、高速なI/Oを実現

イレージャーコーディング

データをあらかじめ冗長性を含む形式に変換するため、分散書込みができない

また前述したように、各社がインスタリカバリなどの機能に備えて高速化するために、よく利用するデータやメタ情報のキャッシュ用にSSDを搭載しているものもあるぞ。

クラスター内部でデータコピーを複数持つRF(レプリケーションファクター)

RF(Replication Factor)とは、コンテナ上で扱うデータの冗長数を表す。クラスター内部でデータのコピーを何個持つかという設定のことじゃ。

RF (Replication Factor)

ノードをまたいでデータをコピーするため、特定のノードに障害が発生しても、冗長化されたデータが複数同時にロストすることはない。「Replication Factor 2」は、データの2重書込、「Replication Factor 3」は、データの3重書き込みを行う。

Replication Factor 2

1台のノード障害までOK。1ノードに障害が発生しても稼働し続ける。

Replication Factor 3

2台のノード障害までOK。2ノードに障害が発生しても稼働し続ける。

RAID、イレージャーコーディング、RFのメリット・デメリット

| 冗長性の技術 | メリット | デメリット |

|---|---|---|

| RAID |

|

|

|

イレイジャー コーディング |

|

|

|

RF |

|

|

次は 「アプライアンス専用特別ライセンス」 についてみていこう!

アプライアンス専用特別ライセンス

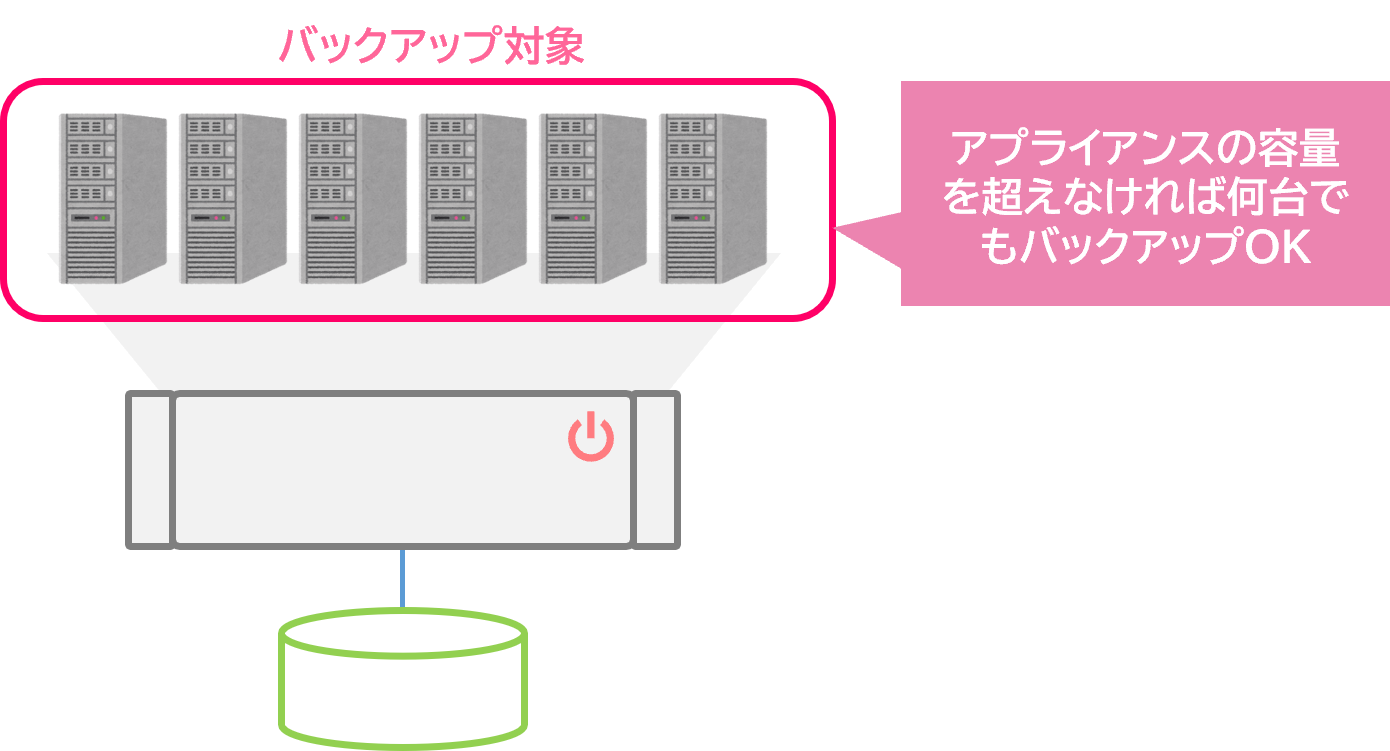

台数に制限なく利用できるのはうれしいですが、いまいちその利用用途がイメージつきません。

例えば最近は在宅ワークやリモートワークなどが増えて、PCを社外に持ち出すことからPCのデータ障害や紛失なども問題になっている。

そこで全PCを対象にバックアップを行い、その分ライセンスが課金されてしまうと、非常に高い料金となってしまう。

リモートワークに潜む様々なデータ損失リスク

全社員のPC台数で数えると費用が高くなる

管理者が意図しない間にバックアップ対象が増える問題もあり、ライセンス規約違反とならないためにも必要なライセンス体系となる。

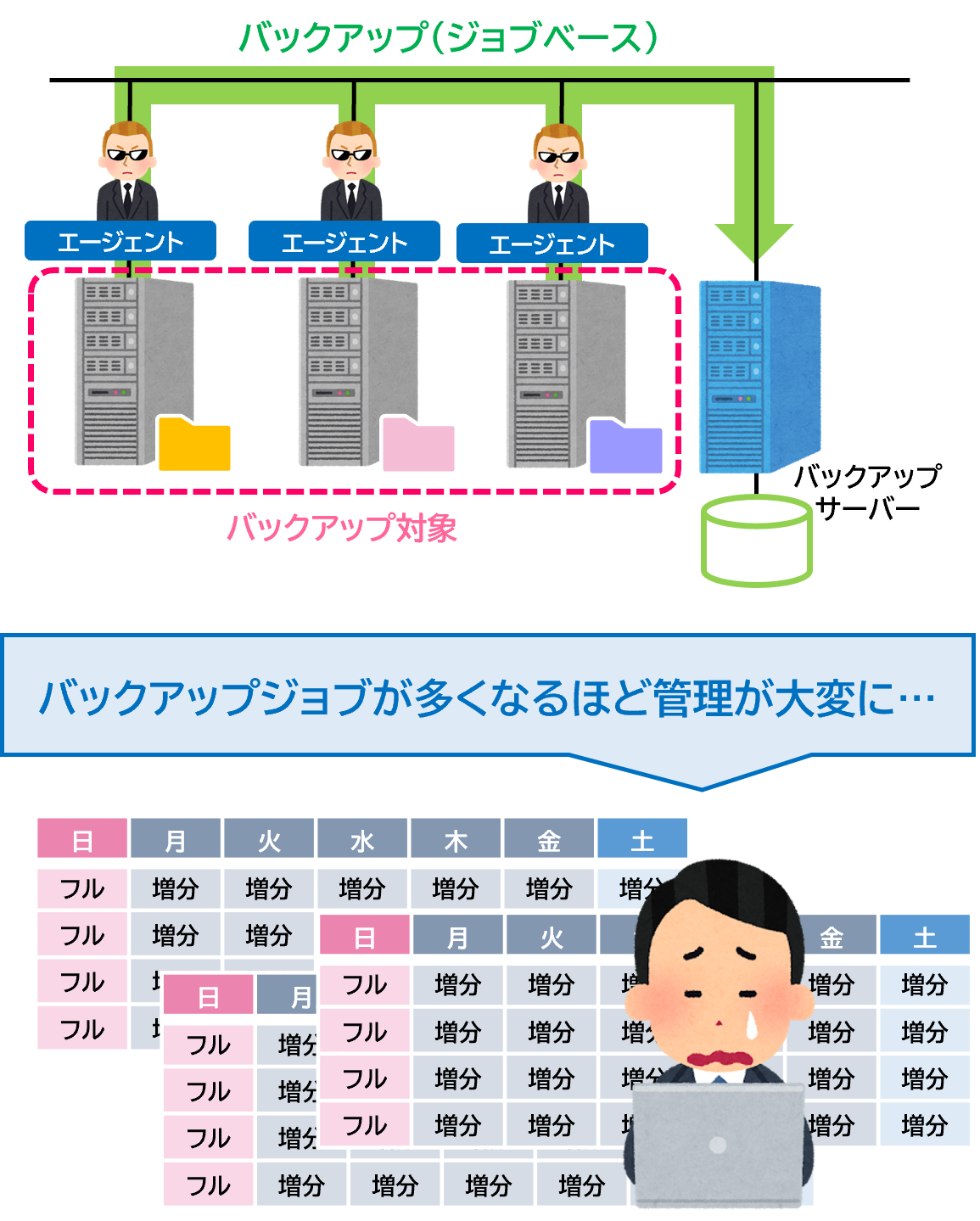

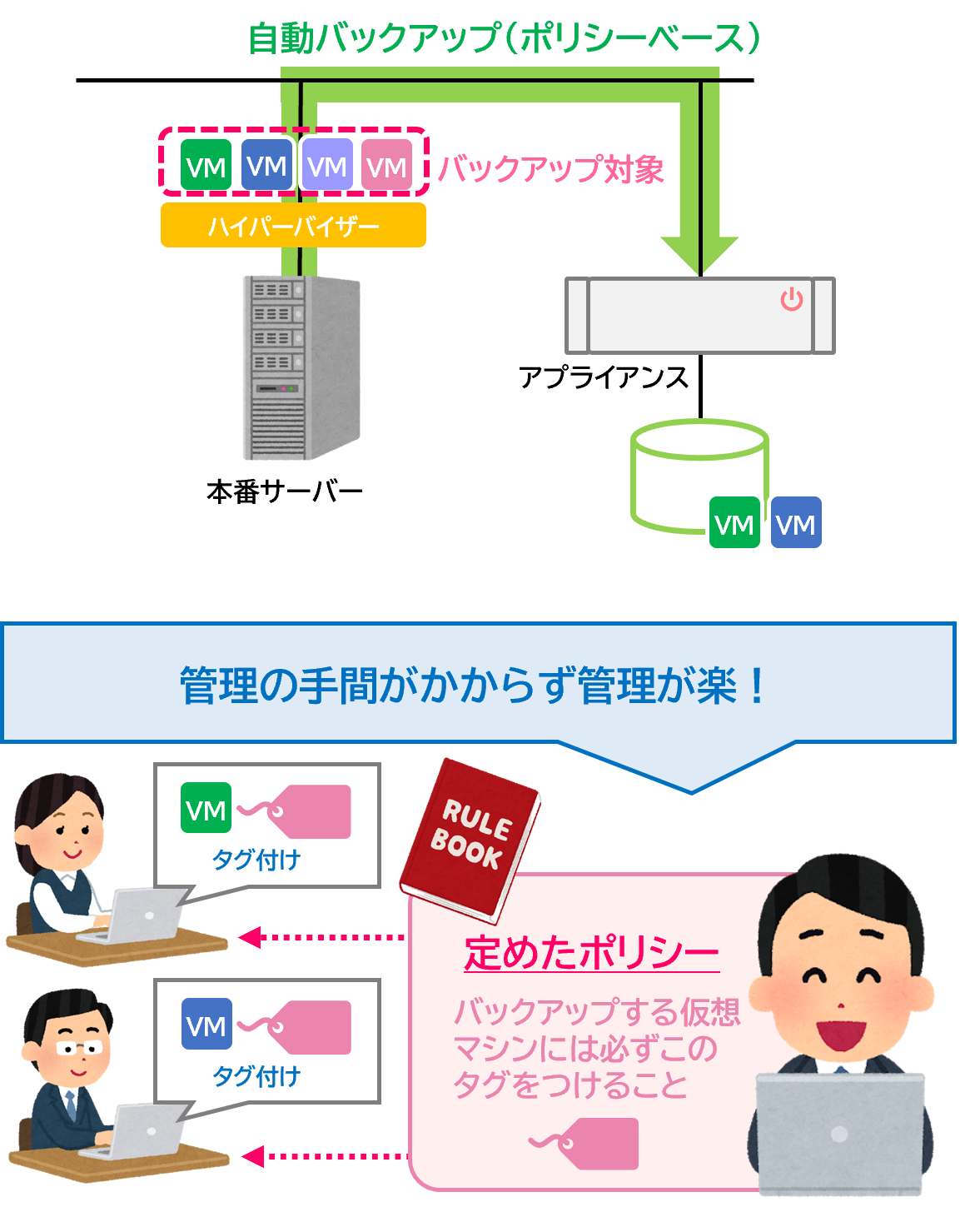

管理者の負荷を削減するポリシーベースのバックアップ

ただ最近は仮想化、コンテナなどの普及により、バックアップする対象が、管理者の意図しないうちに増えていくことも多い。また管理しようとしても現実的に、管理だけで手がいっぱいになってしまい、非常に効率が悪いということもある。

そこで、ある一定のポリシーつまり、ルール決めをするんじゃ。

例えば仮想マシン作成者はバックアップを取ってほしい時には仮想マシンにタグをつけるなどのルールを決めておく。そのルールに一致すれば自動でバックアップを取ってくれる仕組みじゃ。

このように仮想マシンが急に増減するような環境でもポリシーベースは有効じゃ。

ジョブベースバックアップとの違い

ジョブべースのバックアップ

管理者がバックアップジョブ(スケジュール)をバックアップ対象個別に設定する。

ポリシーべースのバックアップ

管理者がポリシーを作成し、そのポリシーに則って自動バックアップを行う。

確かにポリシーベースのバックアップや容量ベースでのライセンスがあることで、バックアップにかかるコストが劇的に削減できそうですね。

まとめ:従来の構成とアプライアンスのメリット・デメリット

ではこのアプライアンス編の最終章で 「従来の構成」、「エントリーモデル」、「スケールアップ」、「スケールアウト」 のパターンでメリット/デメリットを下の表にまとめておいたぞ。よーく見てほしい。

| 従来の構成 | エントリーモデル | スケールアップ | スケールアウト | |

|---|---|---|---|---|

| ノードの追加単位 | × | × | × | 〇 |

| 最低ノード数 | - | - | - | 4ノード~ |

| 異機種の混在 | - | - | 〇 | 〇 |

| 他社認定サーバー の利用 | 〇 | × | × | 〇 |

| ワンストップ保守 | × | 〇 | 〇 | 〇 |

| リモート保守 | × | × | 〇 | 〇 |

| 価格帯(年額) | - | 100万円~ | 700万円~ | 500万円~ |

※上記表はあくまでも各メーカーが公表している情報を元に、おおよその目安としてまとめたものです。

| メリット | デメリット | |

|---|---|---|

| 従来の構成 |

|

|

| エントリーモデル |

|

|

| スケールアップ |

|

|

| スケールアウト |

|

|

守くんとバックアップ博士の会話は参考になりましたか?

管理者の負荷を軽減する便利な機能や、より冗長化を高めるハードウェア構成など、バックアップアプライアンスには多種多様なモデルがリリースされています。

「より冗長性を高めたいが、自社の環境に合った製品選定が難しい」「あまり予算がないが、今よりバックアップ構成をシンプルにしたい」という方は、ぜひネットワールドまでご相談ください。エンドユーザー様に最適な製品をご提案するお手伝いをさせていただきます。

- TOP

- Lv.2_バックアップをもっと学ぶ人が読む記事